传统机器人,例如用于工业和危险环境的机器人,易于建模和控制,但过于僵硬,无法在狭窄空间和不平坦地形中操作。柔软的仿生机器人则更善于适应环境,并在其他难以接近的地方进行操控。

然而,这些更灵活的功能通常需要一系列机载传感器和为每个单独的机器人设计量身定制的空间模型。

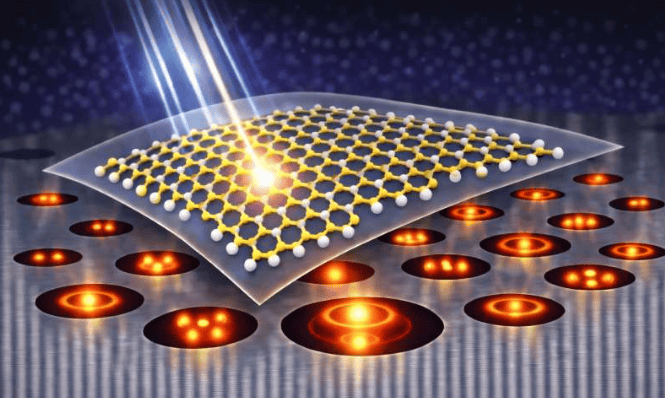

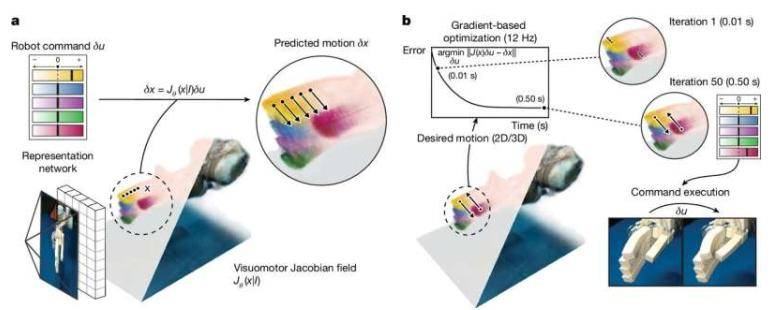

麻省理工学院的一个研究小组采取了一种新的、资源要求较低的方法,开发了一种远不那么复杂的深度学习控制系统,该系统可以教会柔软的、受生物启发的机器人仅通过一张图像移动并遵循命令。

他们的研究结果发表在《自然》杂志上。

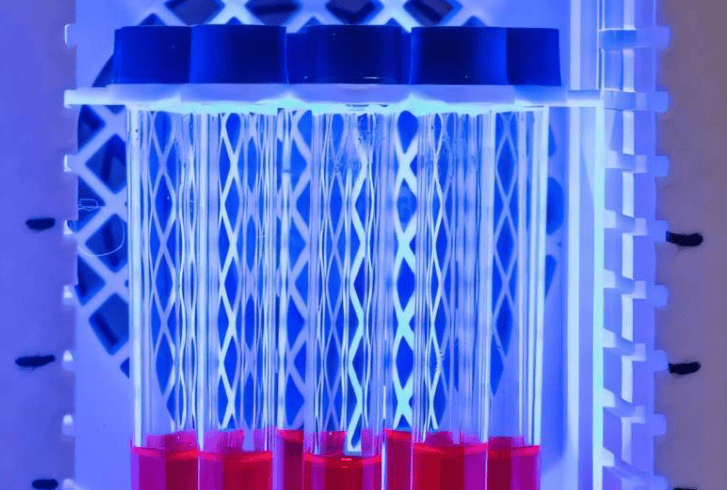

通过对各种机器人执行随机命令的两到三个小时的多视角视频训练深度神经网络,研究人员训练该网络仅从一张图像中重建机器人的形状和移动范围。

以前的机器学习控制设计需要专家定制和昂贵的动作捕捉系统。由于缺乏通用控制系统,它们的应用受到限制,并且使快速原型设计的实用性大大降低。

研究人员在论文中指出:“我们的方法将机器人硬件设计从手动建模的能力中解放出来,而这在过去要求精密制造、昂贵的材料、广泛的传感能力以及对传统刚性构件的依赖。”

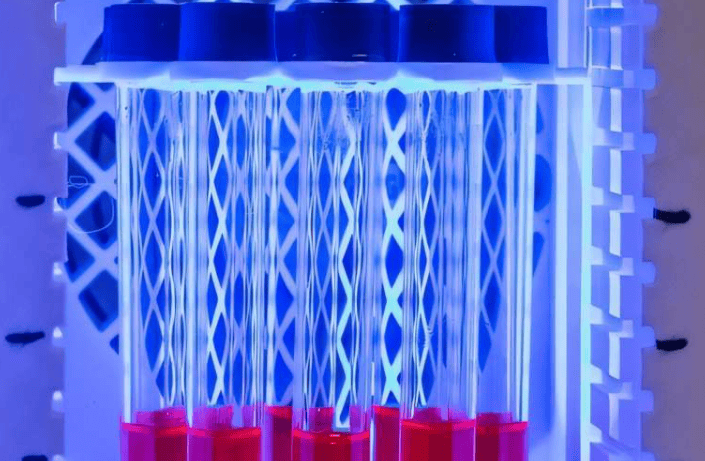

新的单摄像头机器学习方法能够在各种机器人系统的测试中实现高精度控制,包括 3D 打印气动手、软性膨胀腕关节、16-DOF Allegro 手和低成本 Poppy 机械臂。

这些测试成功实现了关节运动误差小于3度,指尖控制误差小于4毫米(约0.15英寸)。该系统还能够补偿机器人的运动和周围环境的变化。

麻省理工学院 (MIT) 的博士生 Sizhe Lester Li 在一篇网络专题文章中指出:“这项研究标志着机器人从编程向教学的转变。”

如今,许多机器人任务需要大量的工程和编码。未来,我们设想向机器人展示应该做什么,并让它自主学习如何实现目标。

由于该系统仅依赖视觉,它可能不适合执行需要接触感知和触觉操控的更灵活的任务。在视觉提示不足的情况下,其性能也可能会下降。

研究人员表示,添加触觉和其他传感器可以使机器人执行更复杂的任务。此外,它还可能实现更广泛的机器人自动化控制,包括那些嵌入传感器极少或没有嵌入传感器的机器人。

更多信息: Sizhe Lester Li 等人,通过深度网络推断雅可比场来控制多样化机器人,《自然》(2025)。期刊信息: 《自然》