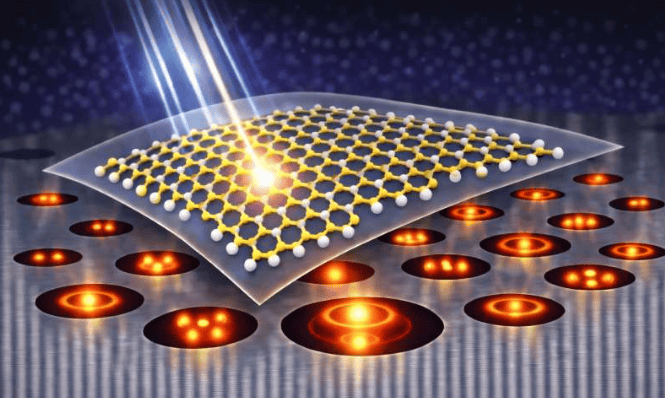

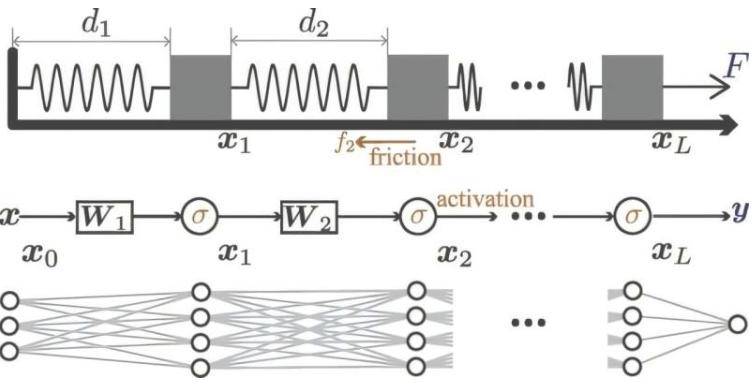

深度神经网络作为人工智能领域的核心技术,其复杂运作机制与性能优化一直是科学界的研究重点。巴塞尔大学数学与计算机科学系Ivan Dokmanić教授团队近期取得突破,通过构建可直观理解的机械模型,成功重现了深度神经网络的关键特征,为优化网络参数提供了新思路。相关研究成果已发表于《物理评论快报》。

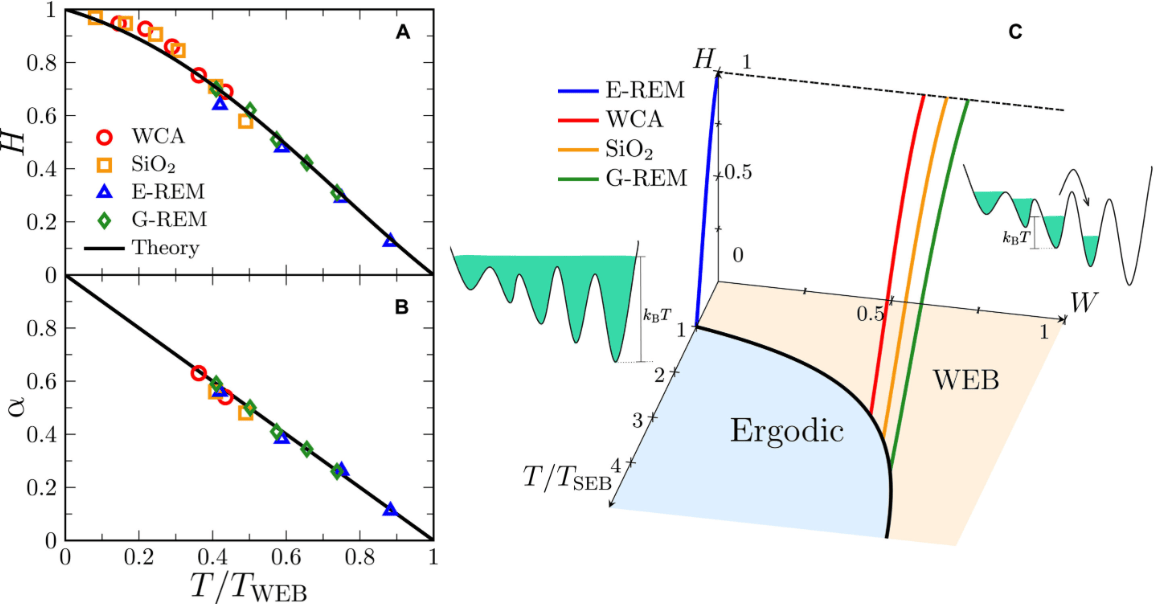

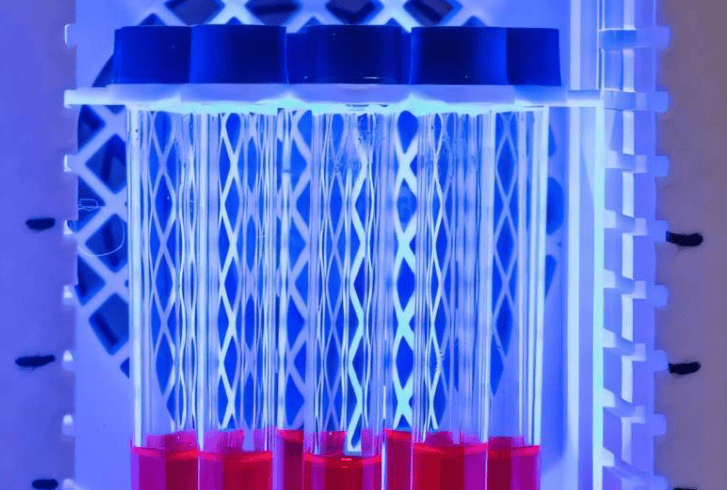

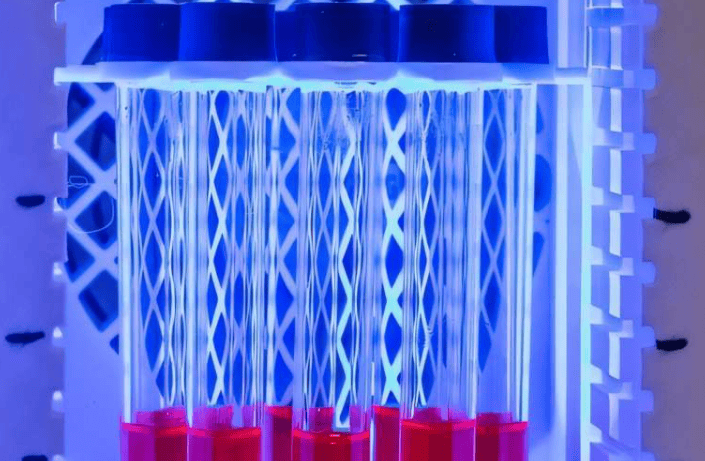

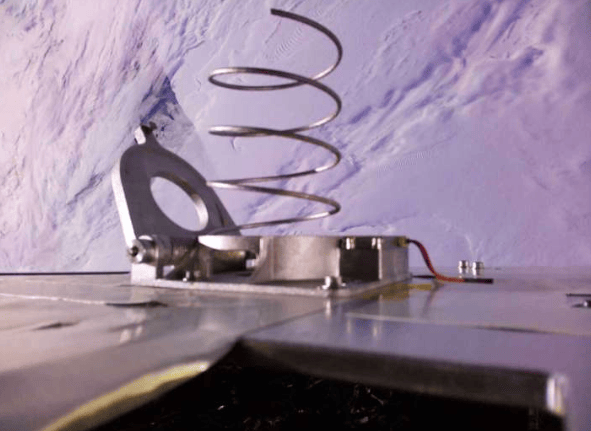

该团队开发的模型以折叠尺为原型,其各部分对应神经网络的不同层。实验中,研究人员通过控制拉动速度与摇晃幅度,模拟神经网络中的非线性计算与随机噪声。程实博士解释道:“缓慢拉动时,折叠尺仅前端展开,对应数据分离集中在浅层;快速拉动并摇晃时,各部分均匀展开,则模拟了数据在各层的均衡分布。”这一发现验证了均衡的数据分离对提升网络性能的重要性,为理解神经网络内部运作机制提供了直观框架。

传统神经网络训练中,非线性计算与噪声的相互作用常导致复杂行为,难以通过数学精确描述。Dokmanić教授团队从物理理论中汲取灵感,通过机械模型将抽象概念具象化。史先生指出:“模拟结果显示,机械模型与真实网络的行为高度一致,这为优化网络结构、减少训练资源消耗提供了理论依据。”目前,团队正将该方法拓展至大型语言模型,未来或可替代传统试错法,实现高性能神经网络的精准训练。

更多信息: Cheng Shi 等,《深度神经网络中特征学习的 Spring-Block 理论》,《物理评论快报》(2025 年)。期刊信息: 《物理评论快报》