随着多模态基础人工智能模型应用的广泛拓展,新的安全漏洞不断浮现,网络安全攻击的可能性也随之增大。洛斯阿拉莫斯国家实验室的研究人员针对这一挑战,提出了一种新颖的框架,旨在识别并抵御针对多模态基础模型(能够无缝集成和处理文本与图像数据的人工智能方法)的对抗性威胁。这一创新成果有助于系统开发人员和安全专家更深入地理解模型漏洞,进而提升防御复杂攻击的能力。

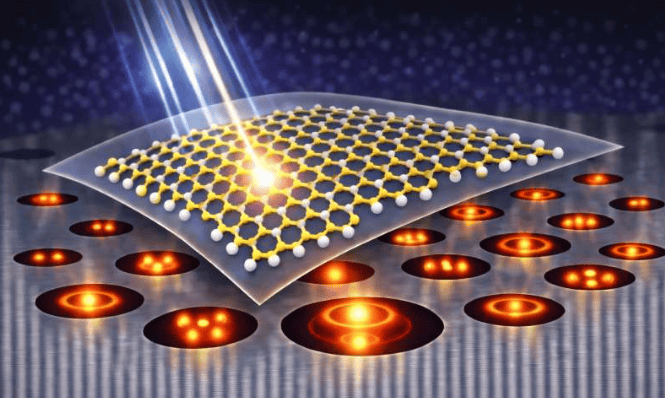

洛斯阿拉莫斯的计算机科学家Manish Bhattarai指出:“多模式模型普及度提升,对手可能通过文本、视觉渠道或两者结合来利用其弱点。”人工智能系统正面临日益严峻的威胁,这些威胁往往源于微妙的恶意操纵,可能误导或破坏模型输出。攻击者可能利用难以察觉的扰动,破坏多模态模型中文本和图像的对齐,从而产生误导性或有害的结果。

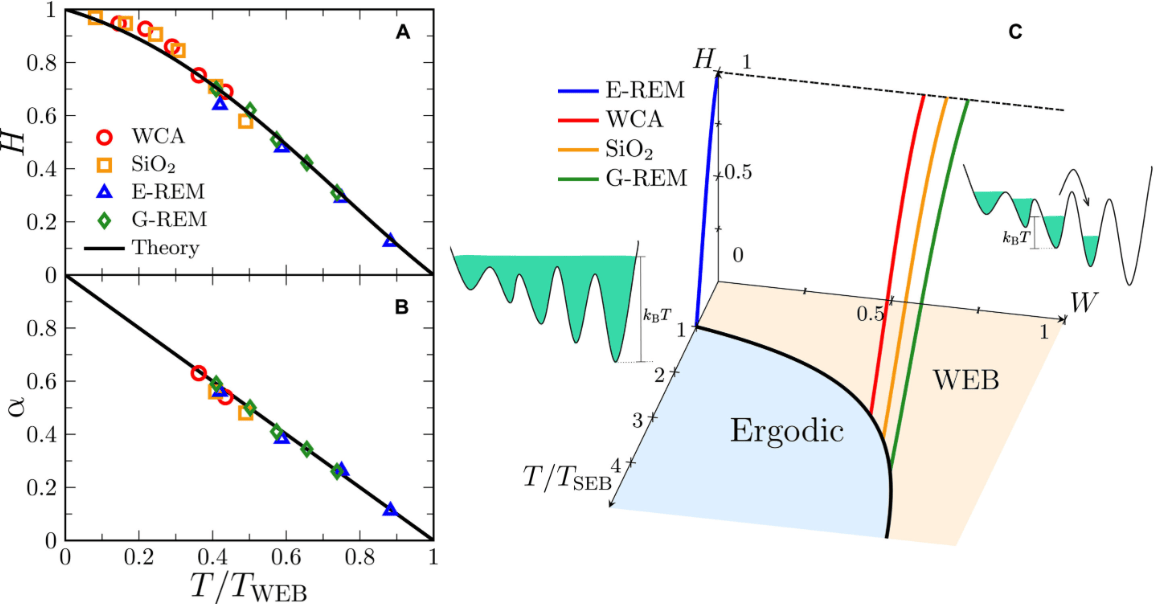

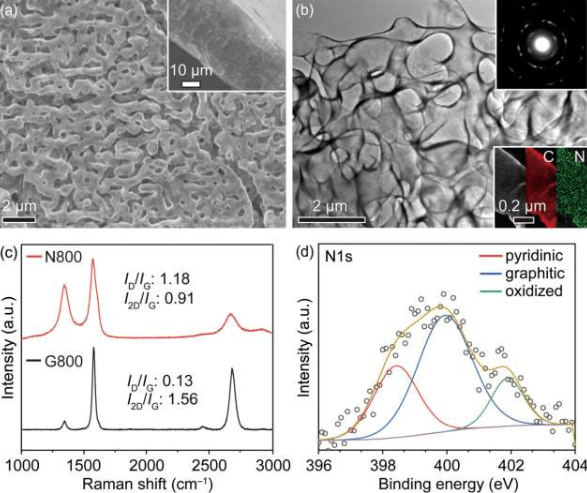

针对这一现状,洛斯阿拉莫斯团队利用拓扑数据分析,开发出一种能够发现对抗性特征的新颖方法。当攻击破坏文本和图像嵌入的几何对齐时,会产生可测量的拓扑扭曲。研究人员通过两种“拓扑对比损失”技术,精确量化这些差异,有效识别对抗性输入。团队成员Minh Vu表示:“我们的算法能准确发现攻击特征,结合统计技术,可高精度检测恶意数据篡改。”

该框架的有效性已在洛斯阿拉莫斯的Venado超级计算机上得到严格验证。该计算机于2024年安装,结合了CPU与GPU,以应对高性能计算和大规模人工智能应用。团队在多个基准数据集和模型中测试了该框架,结果显示,拓扑方法在防御多种已知对抗性攻击方面,显著优于现有措施,提供了更可靠、更有弹性的威胁防御。

更多信息: Minh Vu 等人,《多模态比对中对手的拓扑特征》,arXiv (2025)。期刊信息: arXiv