由科罗拉多大学博尔德分校领导的计算机科学家团队开发了一个新的人工智能平台,可以自动搜索“可疑”的科学期刊。

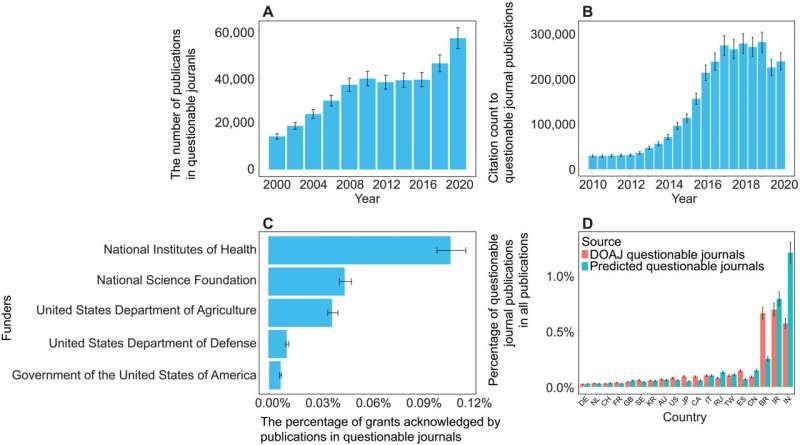

这项研究于 8 月 27 日发表在《科学进展》杂志上,探讨了研究界一个令人担忧的趋势。

这项研究的主要作者、计算机科学系副教授丹尼尔·阿库尼亚 (Daniel Acuña) 每周都会在他的电子邮箱中收到几次这样的提醒:这些垃圾邮件来自自称是科学期刊编辑的人,通常是阿库尼亚从未听说过的期刊,他们提出出版他的论文,但需要支付高额费用。

这类出版物有时被称为“掠夺性”期刊。它们瞄准科学家,说服他们支付数百甚至数千美元,以便在未经适当审查的情况下发表研究成果。

“科学家和机构越来越重视审查这些期刊,”阿库尼亚说。“但这就像打地鼠一样。你抓到一个,然后又出现另一个,通常来自同一家公司。他们只是新建了一个网站,想出了一个新名字。”

他团队的新人工智能工具会自动筛选科学期刊,根据特定标准评估其网站和其他在线数据:这些期刊是否有由资深研究人员组成的编辑委员会?他们的网站是否包含大量语法错误?

Acuña 强调该工具并不完美。他认为,最终应该由人类专家,而不是机器,来评判期刊的信誉。

但他说,在一个知名人士质疑科学合法性的时代,阻止可疑出版物的传播变得比以往任何时候都更加重要。

“在科学领域,你不可能从零开始。你需要在他人研究成果的基础上继续发展,”阿库尼亚说。“所以,如果这座塔的地基崩塌,那么整个塔都会倒塌。”

震荡

当科学家向知名出版物提交一项新研究时,该研究通常会经过同行评审。外部专家会阅读该研究并评估其质量——或者至少,这是最终目标。

越来越多的公司试图绕过这一流程来牟利。2009年,科罗拉多大学丹佛分校的图书管理员杰弗里·比尔(Jeffrey Beall)创造了“掠夺性”期刊一词来形容这些出版物。

他们通常瞄准美国和欧洲以外的研究人员,例如中国、印度和伊朗——这些国家的科研机构可能还很年轻,研究人员发表论文的压力和动力都很大。

“他们会说,‘如果你付 500 美元或 1000 美元,我们就会审查你的论文,’”阿库尼亚说。“实际上,他们不提供任何服务。他们只是把 PDF 文件发布到他们的网站上。”

一些不同的组织试图遏制这种做法。其中包括一个名为“开放获取期刊名录” (DOAJ)的非营利组织。自2003年以来,DOAJ的志愿者根据六项标准将数千种期刊标记为可疑。(例如,信誉良好的出版物往往会在其网站上详细说明其同行评审政策。)

但对于人类来说,跟上这些出版物的传播速度却是一项艰巨的任务。

为了加快这一进程,阿库尼亚和他的同事们求助于人工智能。该团队利用 DOAJ 的数据训练了他们的系统,然后让人工智能筛选互联网上近 15,200 种开放获取期刊的列表。

在这些期刊中,人工智能最初将超过 1,400 种标记为可能存在问题的期刊。

阿库尼亚和他的同事请人类专家审查了部分可疑期刊。据人类专家称,人工智能犯了错误,将大约350份出版物标记为可疑,而这些出版物很可能是合法的。但研究人员仍然认定仍有1000多份期刊存在问题。

“我认为这应该被用来辅助大量期刊的预筛选,”他说,“但最终的分析应该由专业人员来完成。”

阿库尼亚补充说,研究人员不希望他们的系统像其他一些人工智能平台一样成为“黑匣子”。

“例如,使用 ChatGPT 时,你常常不明白它为什么会给出建议,”阿库尼亚说。“我们努力让我们的方案尽可能易于理解。”

例如,研究团队发现,有问题的期刊发表的文章数量异常高。此外,这些期刊的作者所属机构数量也比正规期刊多,而且作者引用自己研究成果而非其他科学家研究成果的比例也异常高。

这套新的人工智能系统目前尚未向公众开放,但研究人员希望很快将其提供给大学和出版公司。阿库尼亚认为,该工具可以帮助研究人员保护其研究领域免受不良数据的影响——他称之为“科学防火墙”。

“作为一名计算机科学家,我经常举新款智能手机上市的例子,”他说,“我们知道这款手机的软件会有缺陷,我们也期待未来能修复漏洞。我们或许应该对科学也采取同样的方法。”

更多信息: Han Zhuang 等,《评估可疑开放获取期刊的可预测性》,《科学进展》(2025 年)。期刊信息: Science Advances