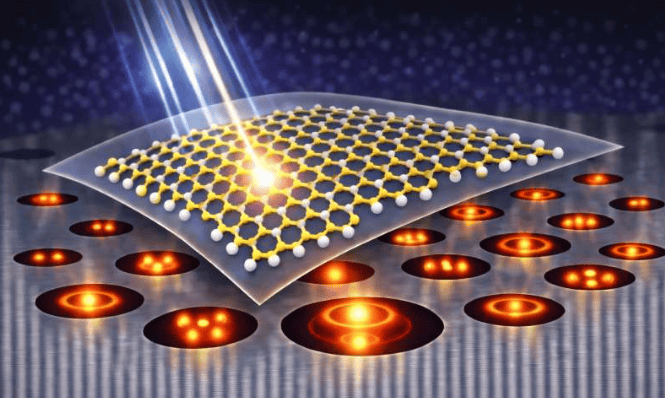

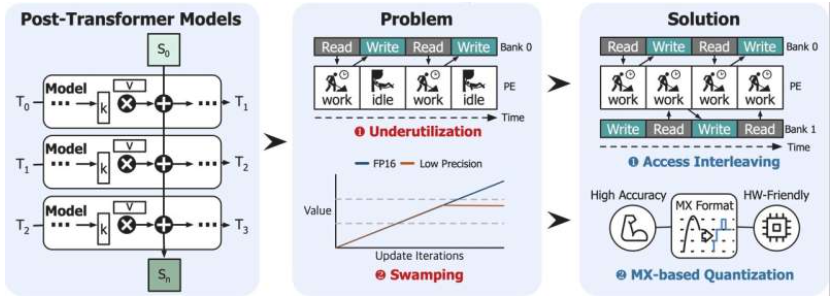

随着人工智能模型处理复杂句子能力的提升,对高效半导体技术的需求愈发迫切。韩国科学技术研究院(KAIST)研究人员携手国际团队,成功开发出基于混合Transformer和Mamba结构的AI半导体“大脑”技术——PIMBA。该技术首次实现内存直接计算,使大型语言模型(LLM)的推理速度提升4倍,功耗降低2.2倍。

由Jongse Park教授领衔的韩国研究团队,联合美国佐治亚理工学院、瑞典乌普萨拉大学,共同研发了PIMBA这一AI内存半导体(PIM)核心技术。该技术作为下一代AI模型的核心,旨在解决当前Transformer结构在处理长句子时面临的计算负载与内存需求激增问题。传统Transformer结构虽能同时感知所有单词,但随着模型规模扩大,速度降低与能耗增加成为主要瓶颈。

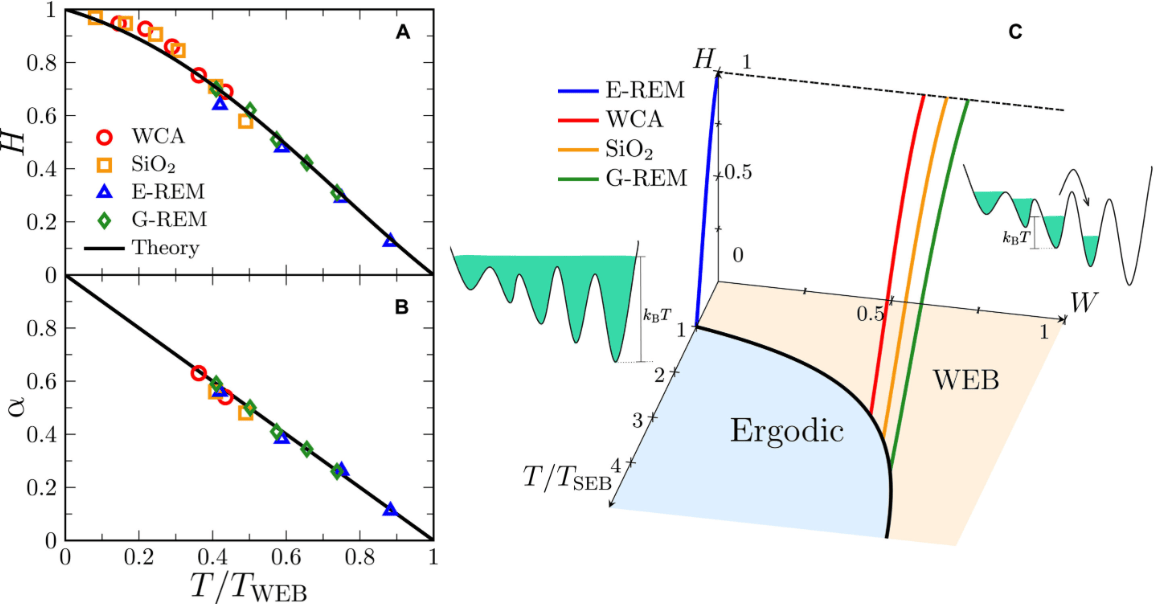

为突破这一局限,研究团队引入了基于顺序内存的Mamba结构,并结合Transformer优势,设计出新型半导体结构PIMBA。PIMBA直接在内存内部进行计算,无需将数据移出内存,从而最大限度减少数据移动时间,显著降低功耗。实验数据显示,与现有GPU系统相比,PIMBA处理性能提升4.1倍,能耗平均降低2.2倍。该研究成果将于第58届国际微架构研讨会(MICRO 2025)上发表,目前已在arXiv预印本服务器公开。

更多信息: Wonung Kim 等人,《Pimba:用于后 Transformer 大型语言模型服务的内存处理加速》期刊信息: arXiv