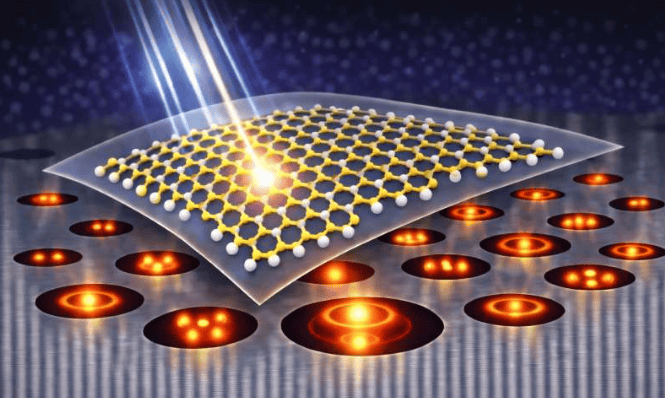

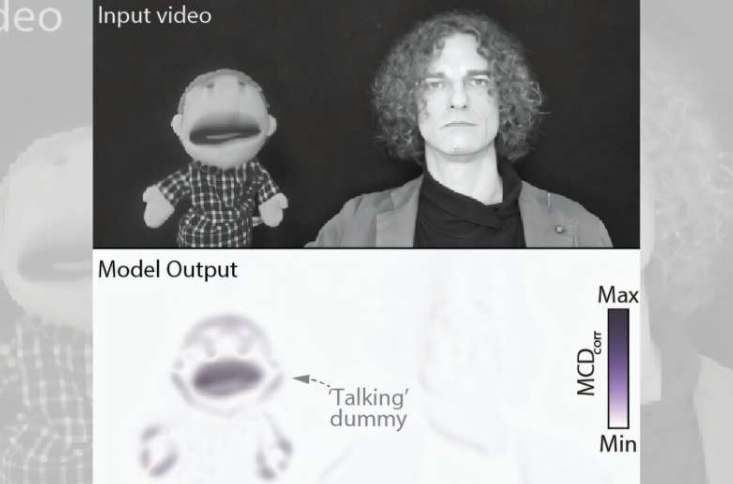

利物浦大学开发的新型计算机模型,以独特方式融合视觉与听觉,模拟人类感知机制。该模型受生物学启发,基于昆虫大脑功能,经心理学高级讲师切萨雷·帕里斯博士改进,能够处理真实视听信号,如视频与声音,而非依赖抽象参数。这一创新成果发表在《eLife》杂志上,为人工智能和机器感知领域带来新突破。

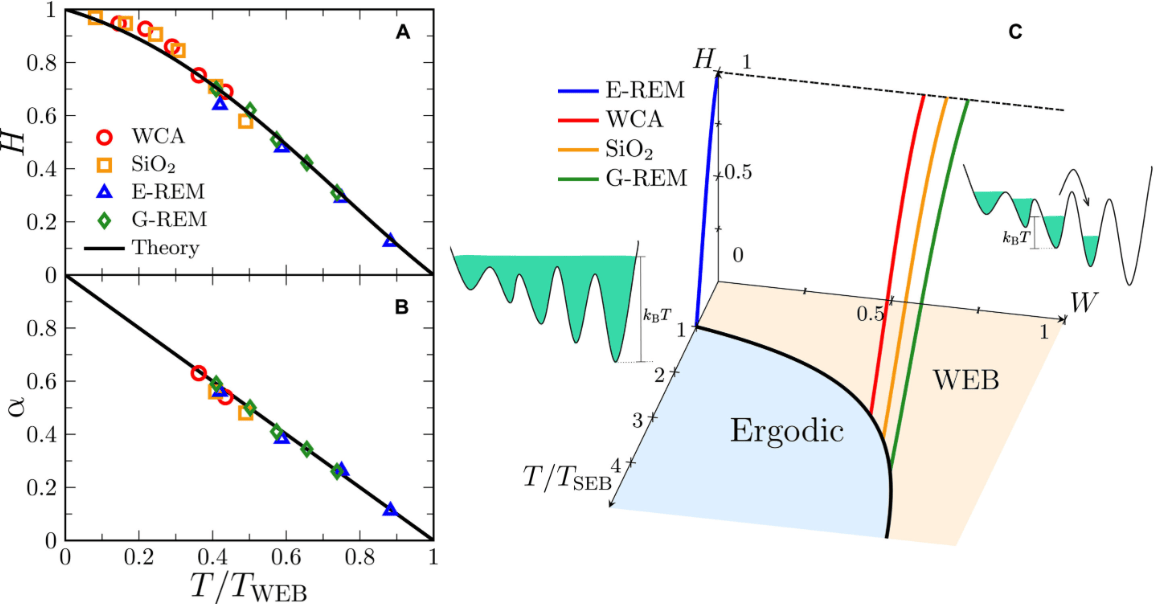

帕里斯博士指出,尽管视听感知研究已持续数十年,但现有模型难以处理真实视听信号,限制了其应用。新模型建立在相关性检测原理之上,通过模拟探测器排列,成功重现69项涉及人类、猴子和老鼠的实验结果,成为该领域规模最大的模拟。该模型不仅能匹配不同物种行为,且性能优于领先的贝叶斯因果推断模型,还能预测人类观看视听电影时的视线落点,作为轻量级“显著性模型”。

“进化已通过简单通用计算解决声音与视觉协调问题,这种计算方式可跨物种和环境扩展。”帕里斯博士强调,新模型直接处理原始视听信号,适用于任何现实世界素材,应用范围超越神经科学。相较于依赖庞大网络和海量标注数据集训练的现有视听显著性模型,新模型轻量级、高效且无需训练,成为下一代应用的有力候选。帕里斯总结道,该模型从昆虫运动视觉研究起步,现已能解释大脑如何整合声音与视觉,为神经科学和人工智能研究提供新蓝图。

更多信息: Cesare V Parise,《相关性检测作为哺乳动物视听感知、因果推理和显著性图谱的刺激可计算解释》,eLife(2025)。期刊信息: eLife