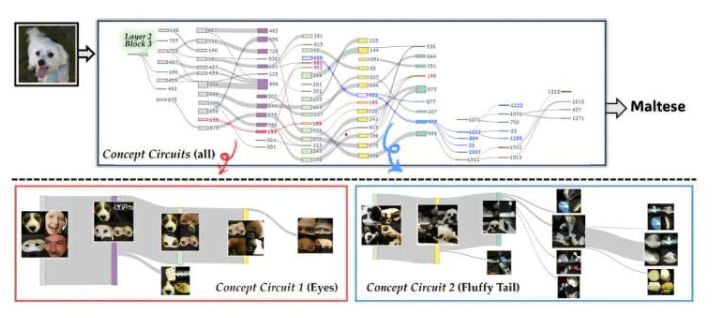

尽管基于深度学习的图像识别技术发展迅速,但人工智能观察和判断图像的标准仍难以解释。分析大规模模型如何结合概念得出结论,一直是尚未解决的重大挑战。韩国科学技术院金宰哲人工智能研究生院崔宰植教授团队,开发出一种新的可解释人工智能(XAI)技术,在电路层面可视化模型内部概念形成过程,帮助人类理解人工智能决策基础。

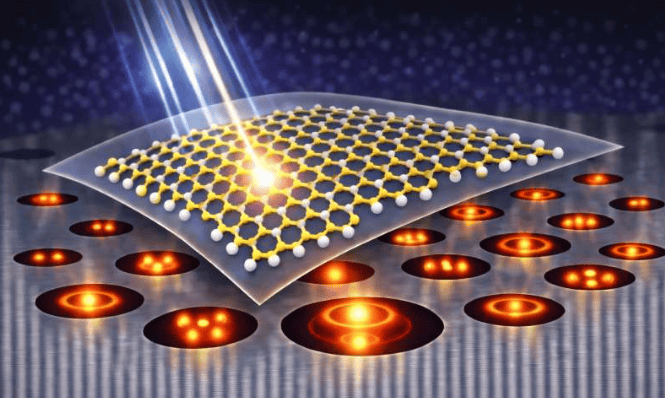

该研究由博士候选人权大熙和李世贤共同担任第一作者,于10月21日在国际计算机视觉会议(ICCV 2025)上发表。在深度学习模型中,神经元检测图像细微特征并传递信号,而回路则是多个神经元相互连接形成的结构,共同识别单一含义。研究团队提出将概念表示单元从“神经元→回路”扩展的技术,开发出“颗粒概念电路(GCC)”技术。

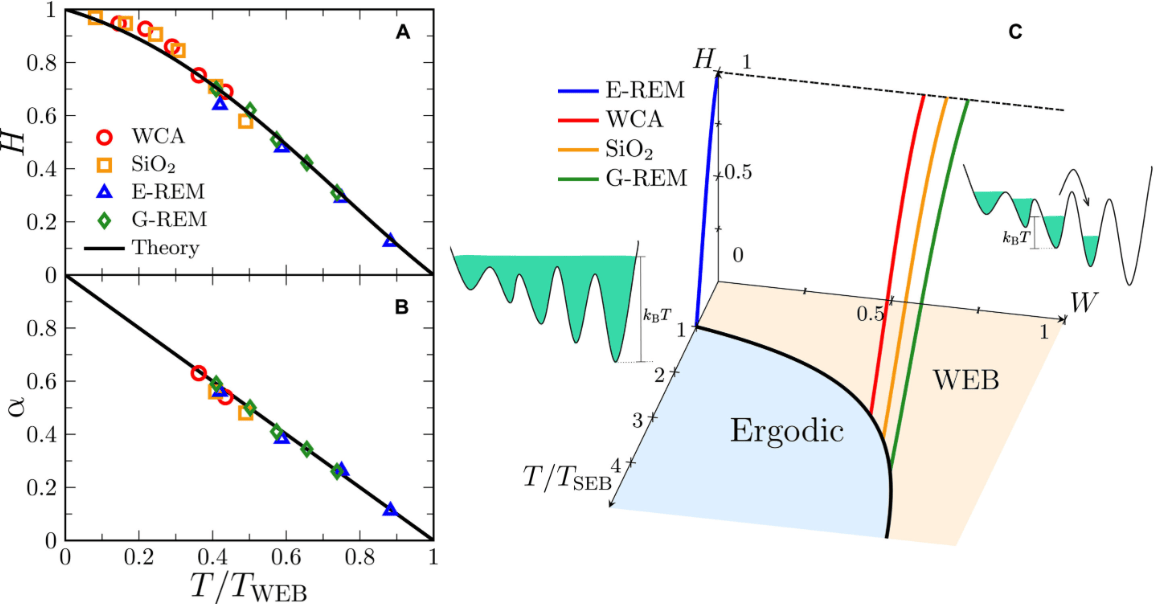

GCC技术通过计算神经元敏感度和语义流,自动追踪神经回路。神经元敏感度表示对特定特征响应强度,语义流衡量特征传递到下一个概念的强度。利用这些指标,系统可逐步可视化基本特征如何组合成更高层次概念。实验表明,禁用特定电路时,人工智能预测结果确实改变,直接证明了相应电路具有识别概念功能。

这项研究首次在精细电路层面揭示复杂深度学习模型内部概念形成实际结构过程,具有实际应用价值,包括增强人工智能决策透明度、分析错误分类原因、检测偏差、改进模型调试和架构,以及提升安全性和问责性。研究团队表示:“这项技术以人类可理解方式展示人工智能内部概念结构,为研究人工智能思维方式提供科学起点。”崔教授强调:“这是首个在细粒度电路层面精确解释模型内部的方法,证明了人工智能学习到的概念可被自动追踪和可视化。”

更多信息: 论文:粒度概念电路:面向概念表示的细粒度电路发现