Zoom Communications 的研究团队近日开发了一项突破性技术——“牵头链”(Chain of Draft,简称 CoD),能够显著降低 AI 系统解决复杂推理问题所需的成本和计算资源。这一技术通过减少文本量并保持甚至提高准确性,为企业大规模部署 AI 提供了新的可能性。

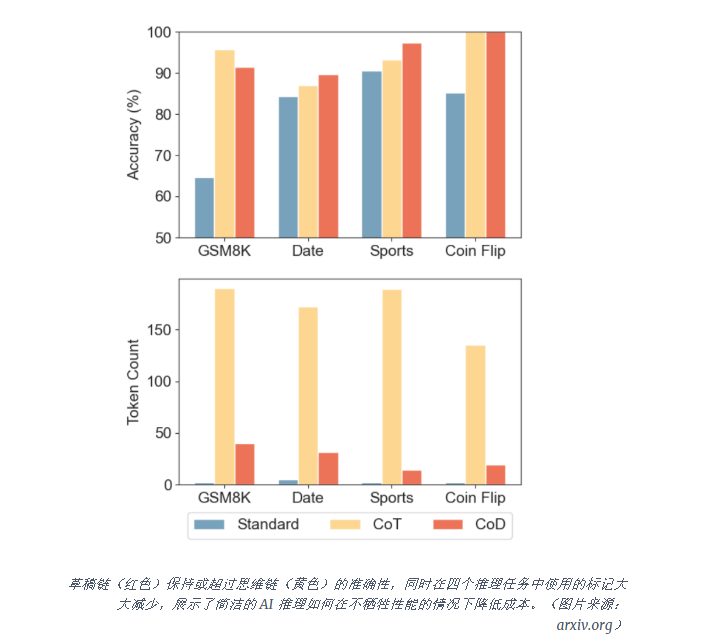

CoD 技术使大型语言模型(LLM)能够以最少的字数解决问题,仅需当前方法所需文本的 7.6%。这一方法不仅降低了成本,还减少了计算资源的消耗。研究团队在上周发布于 arXiv 的论文中指出:“通过减少冗长内容并专注于关键见解,CoD 在准确性上匹配或超过思维链(CoT),同时显著降低了各种推理任务的成本和延迟。”

CoD 的灵感来源于人类解决复杂问题的方式。人们在处理数学问题或逻辑难题时,通常只记录关键信息,而非详细表达每一个细节。研究人员解释道:“在解决复杂任务时,我们通常只记下有助于进展的关键信息。通过模仿这种行为,LLM 可以专注于解决方案,而无需生成冗长的推理过程。”

研究团队在多个基准测试中验证了 CoD 的有效性,包括算术推理(GSM8k)、常识推理(日期理解和运动理解)以及符号推理(抛硬币任务)。在 Claude 3.5 Sonnet 处理体育相关问题的测试中,CoD 将平均输出从 189.4 个令牌减少到仅 14.3 个令牌,减少了 92.4%,同时将准确性从 93.2% 提升至 97.3%。

CoD 技术为企业带来了显著的成本节约。AI 研究员 Ajith Vallath Prabhakar 在分析中指出:“对于每月处理 100 万个推理查询的企业,CoD 可以将成本从 3,800 美元(CoT)降低到 760 美元,每月节省超过 3,000 美元。”这一技术在当前企业 AI 部署的关键时刻尤为重要,因为计算成本和响应时间已成为广泛采用的主要障碍。

传统的 CoT 方法通过将复杂问题分解为分步推理,提高了 AI 解决问题的能力,但其冗长的解释导致计算资源消耗大、响应延迟高。Prabhakar 指出:“CoT 提示的冗长性质会导致大量的计算开销、增加的延迟和更高的运营费用。”

CoD 的另一个优势在于其易于实施。与许多需要昂贵模型重新训练或架构更改的 AI 技术不同,CoD 只需通过简单的提示修改即可与现有模型一起部署。Prabhakar 解释道:“已经在使用 CoT 的组织可以通过简单的提示修改切换到 CoD。”

这一技术特别适用于对延迟敏感的应用程序,如实时客户支持、移动 AI、教育工具和金融服务。在这些场景中,即使是很小的延迟也会显著影响用户体验。此外,CoD 的普及还可能使小型组织和资源受限环境更容易访问复杂的 AI 功能。

随着 AI 系统的不断发展,CoD 等技术凸显了对效率和原始能力的日益重视。Prabhakar 总结道:“随着 AI 模型的不断发展,优化推理效率将与提高其原始能力同样重要。”研究团队已将代码和数据公开在 GitHub 上,供企业和开发者测试和实施这一方法。