在人工智能(AI)快速发展的当下,为其提供支持的计算机数量持续攀升,然而这一增长态势给运行AI模型的数据中心带来了巨大压力,其能耗达到前所未有的高度。

如今,AI模型愈发庞大复杂,最先进的系统拥有数十亿个参数,在数千个计算机芯片上运行。为跟上发展步伐,各大公司不断增加硬件、芯片、内存和网络等,这种“蛮力”方法虽助力AI取得巨大飞跃,却也使数据中心成为耗能大户。部分科技公司甚至寻求用化石燃料和核电站为数据中心供电,同时也刺激了制造更高效计算机芯片的努力。

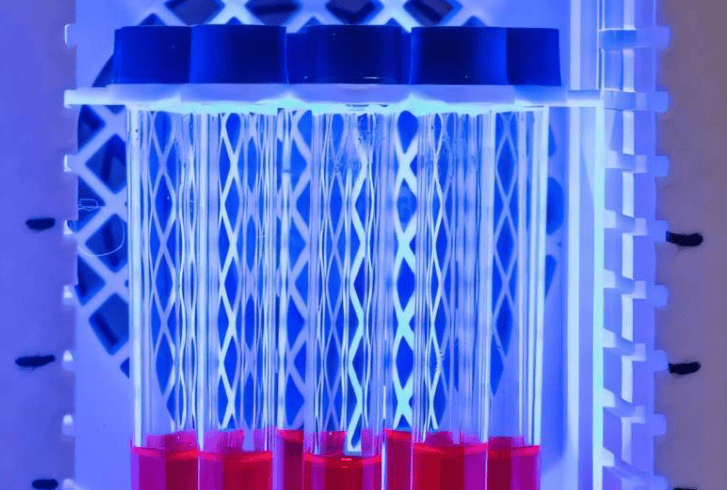

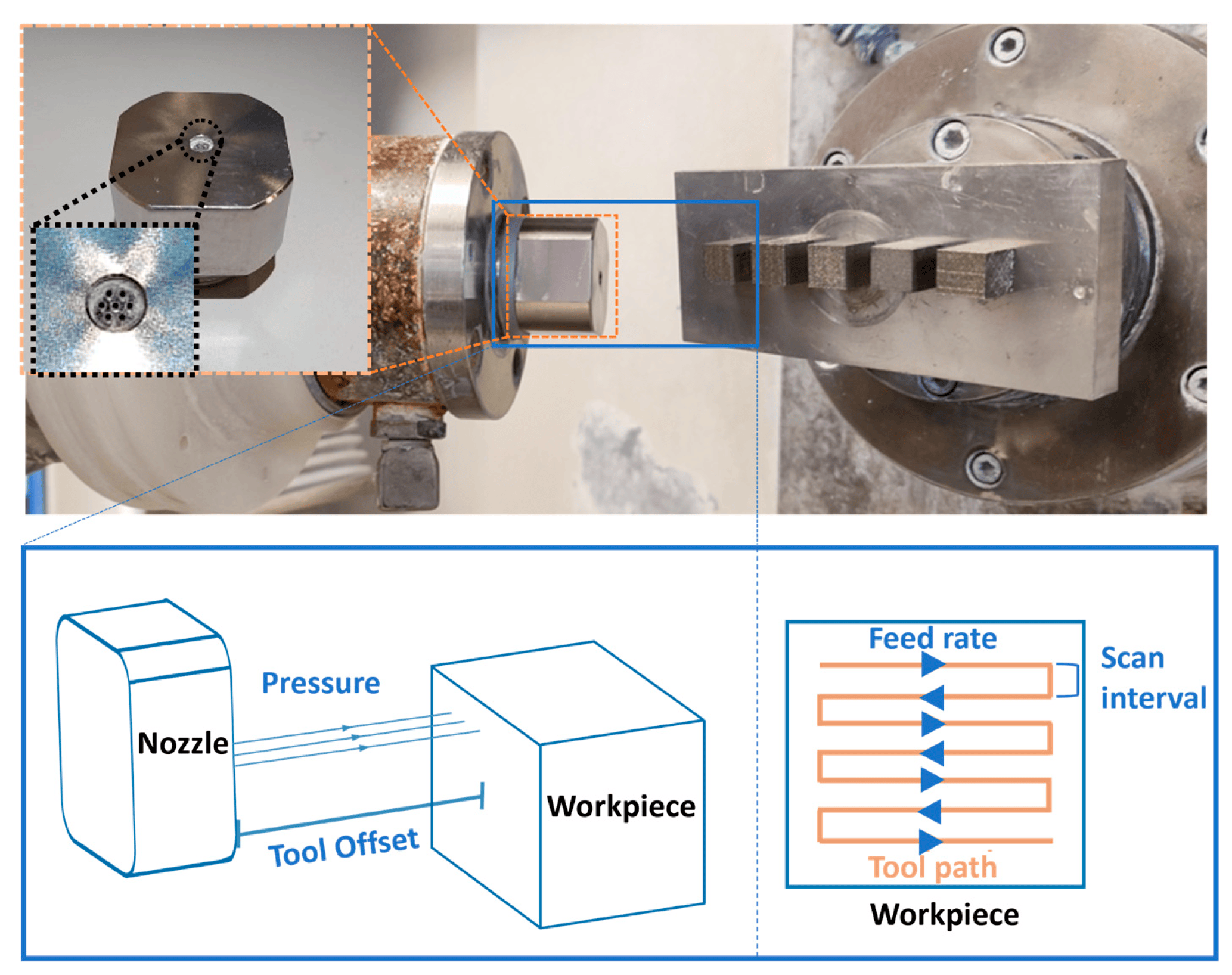

现代AI数据中心耗电量堪比一座小城市,且耗电环节不止计算,内存和冷却系统也是主要耗能因素。随着AI模型发展,存储需求增大、数据访问速度加快,产生更多热量,芯片性能提升也使散热成为核心挑战。传统冷却方式成本高,液体冷却等新方法虽有用,但需精心规划和水资源管理,若无更智能方案,AI能源需求和成本将难以承受。

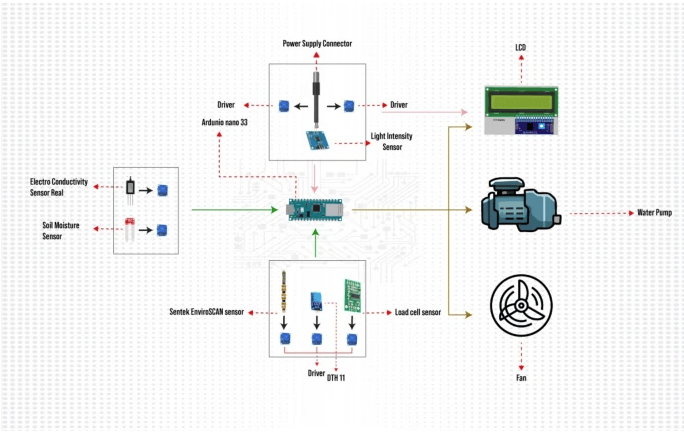

即便拥有先进设备,许多数据中心仍运行效率低下,原因是系统不同部分缺乏通信。例如调度软件不知芯片过热或网络堵塞,导致服务器闲置或难以跟上需求,造成能源浪费和资源利用不足。

应对这一挑战,需重新设计和管理支持AI的系统,摒弃蛮力扩张,转向更智能、专业的基础设施。具体有三个关键思路:

一是解决硬件差异性。同一代芯片在运行速度和散热能力上也有差异,数据中心计算机系统应识别这些差异并调整。

二是适应不断变化的环境。AI工作负载随时间变化,系统应实时响应温度、电源可用性和数据流量等因素。

三是打破各自为政。设计芯片、软件和数据中心的工程师应携手合作。佐治亚理工学院的AI Makerspace(高性能AI数据中心)就开展了跨学科合作,从硬件到软件再到能源系统,构建和测试高效、可扩展且可持续的AI系统。

AI有潜力改变诸多领域,但面临性能、能源和成本限制。其未来不仅取决于更完善的模型,更取决于更完善的基础设施。从强制扩展转向智能扩展,对推动AI以造福社会的方式发展至关重要。