麻省理工学院计算机科学与人工智能实验室(CSAIL)的科学家们开发出一种名为“神经雅可比场”(NJF)的全新机器人控制系统,为机器人技术带来了革命性的变革。该系统突破了传统机器人依赖复杂传感器和手工设计模型的局限,仅通过视觉数据即可实现机器人的精准控制。相关研究成果已发表于《自然》杂志。

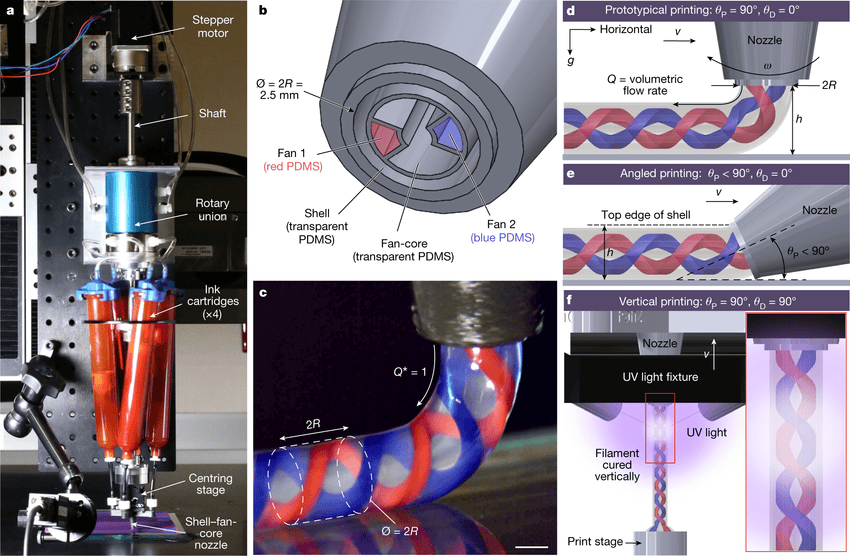

传统机器人通常设计为刚性结构,并配备丰富的传感器,以便构建精确的数字孪生模型进行控制。然而,随着机器人技术向柔性、仿生方向发展,这些方法在软体机器人和不规则形状机器人上的应用变得困难重重。NJF系统则颠覆了这一传统,它允许机器人通过观察自身运动来学习内部模型,从而实现自我控制。

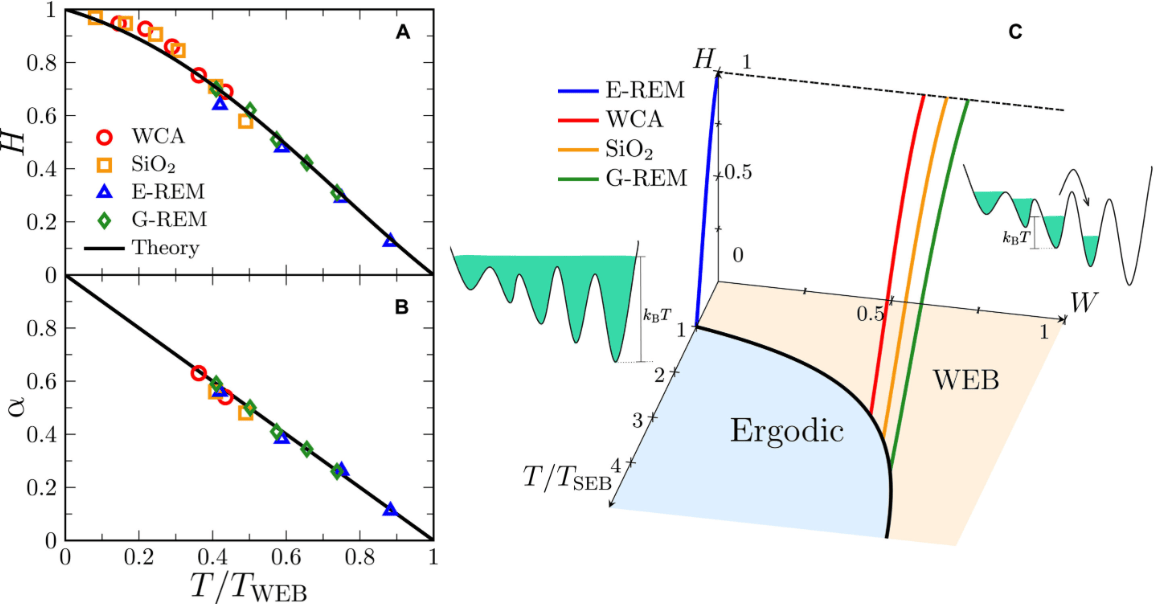

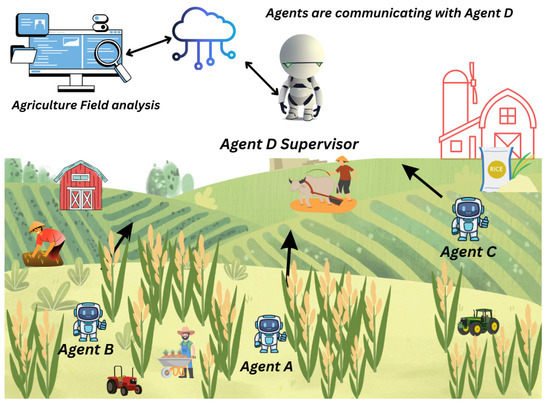

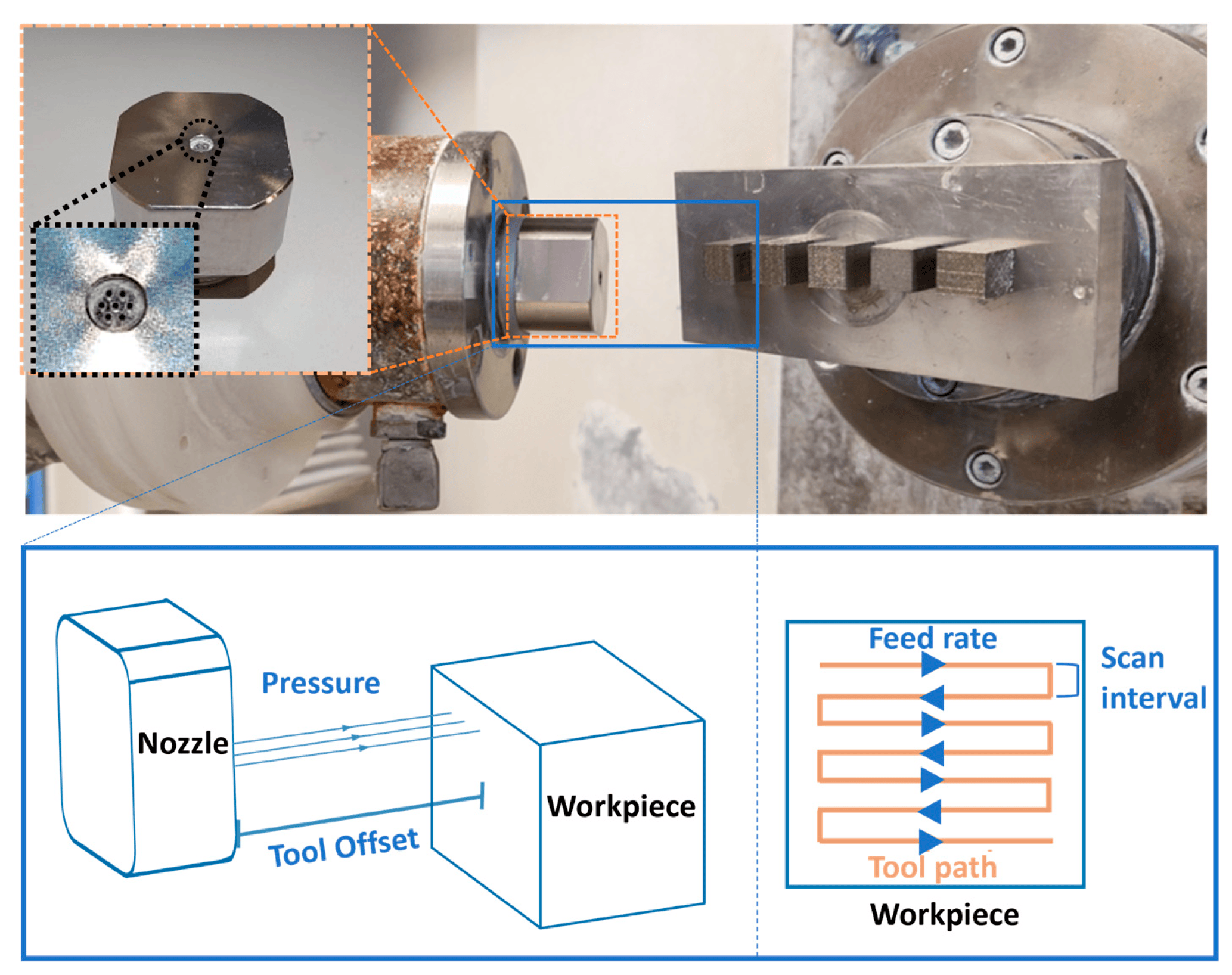

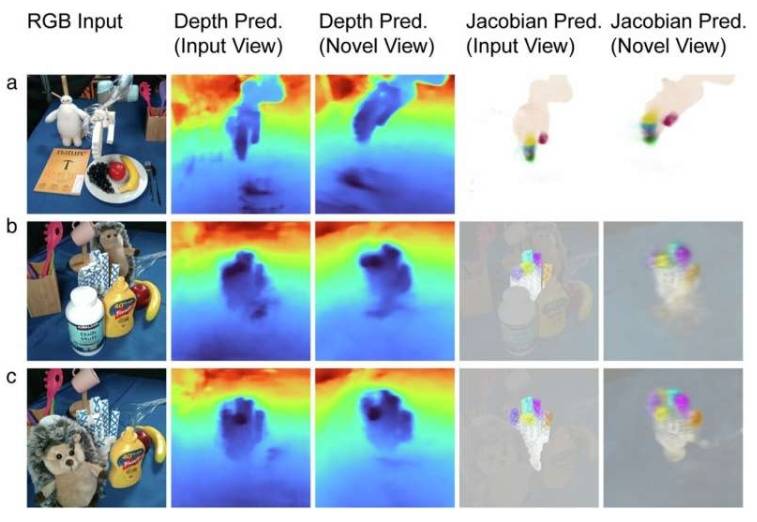

NJF系统的核心是一个神经网络,它结合了神经辐射场(NeRF)技术,不仅学习机器人的三维几何形状,还学习雅可比场——一种预测机器人身体上任何一点如何响应运动指令而移动的函数。通过让机器人执行随机运动,并利用多个摄像头记录结果,NJF系统无需人工监督或事先了解机器人结构,即可推断出控制信号和运动之间的关系。

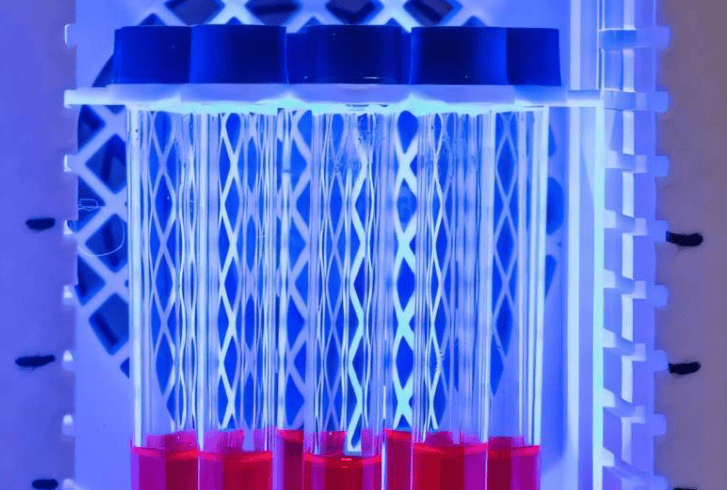

研究团队在多种类型的机器人上测试了NJF系统,包括气动软体机械手、刚性Allegro机械手、3D打印机械臂,甚至没有嵌入式传感器的旋转平台。在每种情况下,系统仅通过视觉和随机运动就能了解机器人的形状及其对控制信号的响应,实现了厘米级定位精度的实时闭环控制。

麻省理工学院电气工程与计算机科学博士生、CSAIL附属机构研究员Sizhe Lester Li表示:“这项工作标志着机器人从编程向教学的转变。未来,我们设想向机器人展示任务,并让它自主学习如何实现目标,就像人发现新设备上的按钮一样自然。”

NJF系统的出现,为机器人设计带来了前所未有的自由度。设计师可以探索非传统、不受约束的机器人形态,而无需担心建模或控制的复杂性。此外,该系统还降低了机器人技术的门槛,使得价格实惠、适应性强的机器人成为可能。

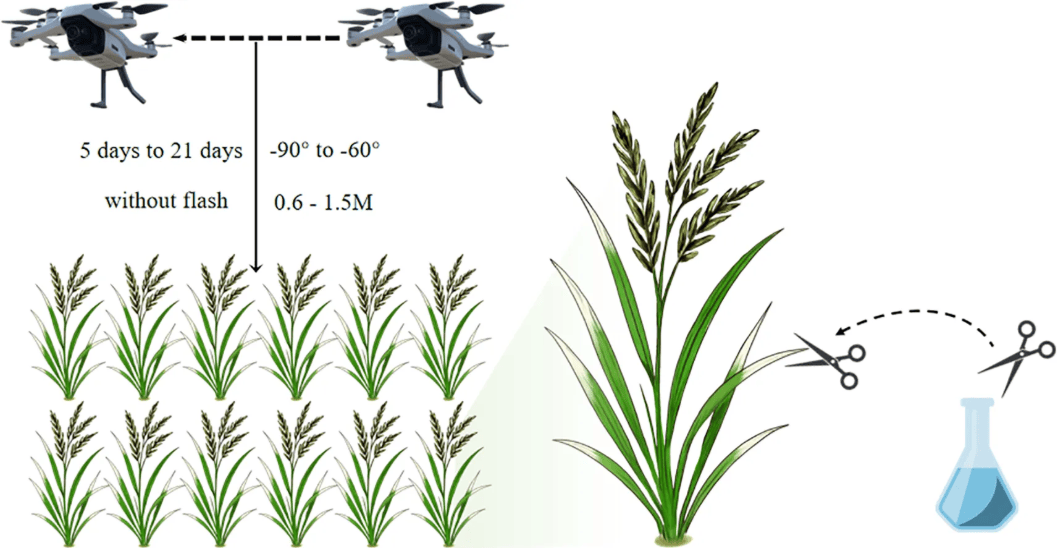

麻省理工学院助理教授、场景表征小组负责人Vincent Sitzmann指出:“视觉是一种灵活可靠的传感器,它为机器人打开了在混乱、非结构化环境中运行的大门,如农场、建筑工地等,而无需昂贵的基础设施。”

尽管目前NJF系统还需要为每个机器人重新训练,并且缺乏力觉或触觉感知,但研究人员正在积极探索新的方法来突破这些限制。他们设想,未来爱好者可以用手机记录机器人的随机动作,然后使用这些视频创建控制模型,无需任何先验知识或特殊设备。

“就像人类对身体如何移动和响应命令有了直观的理解一样,NJF仅通过视觉就能让机器人拥有这种体现自我意识,”Li说道,“这种理解为在现实环境中灵活操作和控制奠定了基础,反映了机器人技术从手动编程向通过观察和交互来教授机器人的更广泛趋势。”

更多信息: Sizhe Lester Li 等人,通过深度网络推断雅可比场来控制多样化机器人,《自然》(2025)。