近日,杜克大学的研究团队取得了一项重要突破,他们开发了一个名为WildFusion的全新框架,旨在让机器人能够像人类一样通过多种感官“感知”复杂的户外环境。这一成果标志着机器人在非结构化、不可预测环境中的导航和地图绘制能力迈出了重要一步。

人类的感官系统为我们提供了丰富的信息,使我们能够感知周围的世界。触觉、嗅觉、听觉以及平衡感在应对日常环境时至关重要。相比之下,机器人长期以来主要依赖摄像头或激光雷达等视觉信息进行导航,在复杂多变的现实世界中,这种单一感官依赖往往显得捉襟见肘。

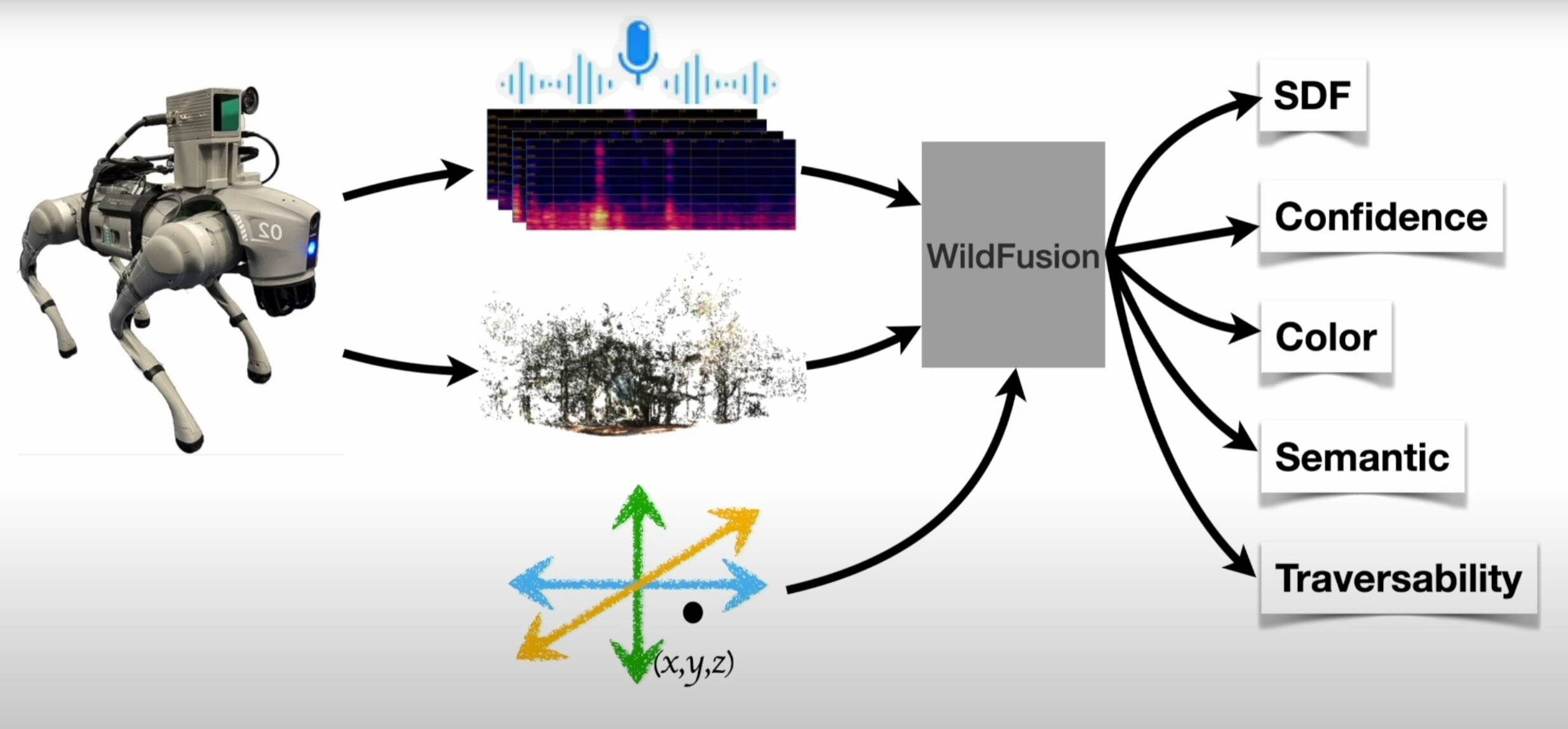

杜克大学的研究人员敏锐地捕捉到了这一挑战,并着手开发WildFusion框架。该框架融合了视觉、振动和触觉等多种感官数据,使机器人能够在森林、灾区和越野地形等复杂环境中更加自信地运行。研究团队表示,WildFusion开启了机器人导航和3D地图绘制的新篇章。

“典型的机器人严重依赖视觉或激光雷达,在缺乏清晰路径或可预测地标的情况下,它们往往会失效,”该研究的第一作者刘彦百辉指出。而WildFusion的独特之处在于它利用了声波振动和触觉,为机器人提供了更加全面的环境感知能力。

WildFusion基于四足机器人构建,集成了RGB摄像头、激光雷达、惯性传感器、接触式麦克风和触觉传感器等多种传感模块。这些传感器捕捉到的数据通过专门的编码器进行处理,并融合成单一且丰富的表征。深度学习模型的应用使得机器人能够在视觉受阻或模糊的情况下,依然能够做出智能、直观的决策。

在北卡罗来纳州杜克大学校园附近的伊诺河州立公园进行的测试中,WildFusion成功帮助机器人穿越了茂密的森林、草地和碎石路。这些实际测试证明了WildFusion精准预测可穿越性的能力,显著提高了机器人在复杂地形中安全路径的决策能力。

展望未来,研究团队计划通过加入额外的传感器来扩展该系统,以进一步增强机器人理解和适应复杂环境的能力。WildFusion凭借其灵活的模块化设计,在森林小径之外,还提供了广阔的潜在应用,包括灾难响应、检查远程基础设施和自主探索等领域。

更多信息: Yanbaihui Liu 等,WildFusion:野外多模态隐式 3D 重建,arXiv (2024)。期刊信息: arXiv

京公网安备 11010802043282号

京公网安备 11010802043282号