想象一下,用希腊语向 Claude 或 ChatGPT 这样的对话机器人询问一个关于当地交通法规的法律问题。几秒钟内,它就能用流利的希腊语给出基于英国法律的答案。该模型理解语言,但不理解司法管辖权。这种失败表明,大型语言模型 (LLM) 无法理解地域、文化以及法律知识,同时又精通世界上许多语言。

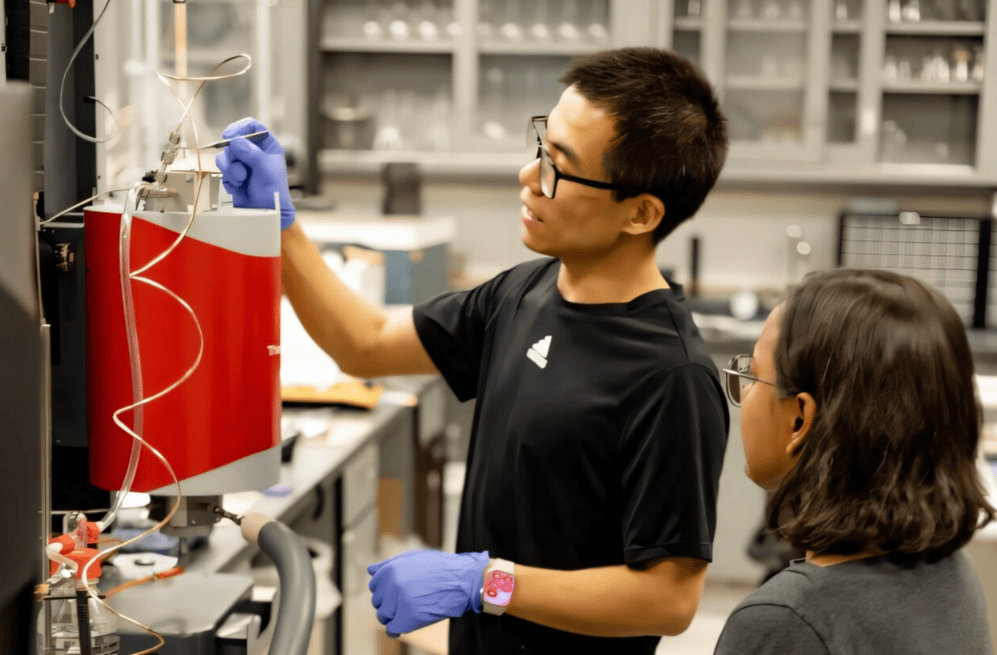

INCLUDE 由来自 EPFL 自然语言处理实验室、Cohere 实验室以及全球合作伙伴的团队共同开发。这款工具代表着我们朝着更贴合本地情境的人工智能迈出了重要一步。

该基准不仅能够评估法学硕士(LLM)在特定语言方面的准确性,还能评估其是否能够融入与其相关的文化和社会文化现实。这种方法与瑞士人工智能倡议的目标相契合,即创建反映瑞士语言和价值观的模型。该研究已发表在arXiv预印本服务器上。

“为了与时俱进,法学硕士需要了解文化和地域差异。这不仅关乎全球知识,更关乎满足用户所在地的需求,”洛桑联邦理工学院 (EPFL) NLP 实验室博士助理、该基准测试的第一作者 Angelika Romanou 说道。

多语言人工智能的盲点

GPT-4 和 LLaMA-3 等法学硕士 (LLM) 在生成和理解数十种语言的文本方面取得了令人瞩目的进步。然而,即使是像乌尔都语或旁遮普语这样广泛使用的语言,它们的效果也往往不佳,原因在于缺乏足够的高质量训练数据。

现有的大多数法学硕士(LLM)评估基准要么是纯英文的,要么是从英语翻译过来的,这带来了偏见和文化扭曲。翻译后的基准常常存在翻译错误或措辞不自然等问题,俗称“翻译腔”。此外,大多数现有基准仍然保留着以西方为中心的文化偏见,未能反映目标语言独特的语言和地域特征。

INCLUDE 采取了不同的方法。团队没有依赖翻译,而是从本地学术、专业和职业考试中收集了超过 197,000 道多项选择题。

所有试题均以44种语言和15种文字为母语编写。试题由母语人士直接编写,真实试题来自各个权威机构,涵盖文学、法律、医学和海事执照等各个领域。

该基准既捕捉了显性的地域知识(例如地方法律),也捕捉了隐性的文化线索(例如社会规范或历史视角)。在测试中,模型在地域历史方面的表现始终逊于一般世界历史——即使是在同一种语言中也是如此。换句话说,人工智能尚不了解当地背景。

例如,当问到印度人穿什么样的传统服饰时,无论使用哪种语言,答案总是“纱丽”。然而,当问到“亚历山大大帝为什么在公元前330年放火焚烧波斯波利斯?”时,目前的模型并不能体现出地域差异。

“波斯语系的叙事可能将其视为对波斯文化和社会的不尊重,而希腊语系的叙事可能将其描述为对波斯人薛西斯入侵希腊的报复。这种带有文化色彩的解读对人工智能构成了真正的挑战,”NLP 实验室博士助理、基准测试的合著者 Negar Foroutan 说道。

当前模型的结果好坏参半

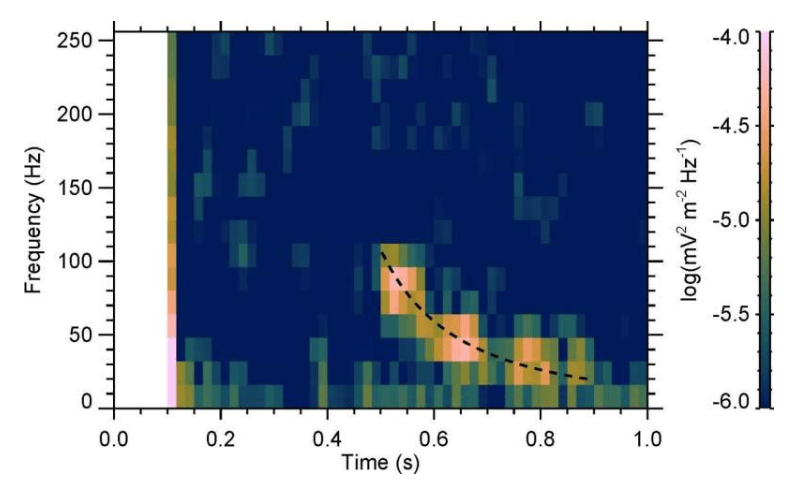

研究团队评估了包括 GPT-4o、LLaMA-3 和 Aya-expanse 在内的领先模型,并根据语言主题评估了其性能。GPT-4o 的整体表现最佳,在所有领域的平均准确率约为 77%。

虽然模特们在法语和西班牙语方面表现不错,但在亚美尼亚语、希腊语和乌尔都语等语言方面却表现不佳,尤其是在涉及文化或专业背景的话题上。她们常常默认西方的假设,或者给出自信满满却错误的答案。

迈向更具包容性的人工智能

INCLUDE 超越了简单的技术基准。随着人工智能系统在教育、医疗保健、治理和法律领域的应用日益广泛,区域理解变得至关重要。“随着人工智能的民主化,这些模型需要适应不同社群的世界观和现实生活,”自然语言处理实验室负责人 Antoine Bosselut 表示。

INCLUDE 已公开发布,并已被一些最大的法学硕士 (LLM) 提供商采用,它提供了一个实用工具,帮助我们重新思考如何以更公平和包容的方式评估和训练 AI 模型。团队正在开发新版本的基准,并将覆盖范围扩展到约 100 种语言,包括比利时法语、加拿大法语和瑞士法语等地区性语言,以及非洲和拉丁美洲一些代表性不足的语言。

随着 INCLUDE 等基准的广泛采用,它们或许有助于塑造负责任的人工智能的国际标准,甚至监管框架。它们也为医学、法律和教育等关键领域的专业模型铺平了道路,因为了解当地情况至关重要。

更多信息: Angelika Romanou 等,INCLUDE:利用区域知识评估多语言理解,arXiv (2024)。期刊信息: arXiv