加州大学河滨分校的一个计算机科学家团队开发了一种方法,可以从人工智能模型中删除私人和受版权保护的数据,而无需访问原始训练数据。

这一进展在 7 月份于加拿大温哥华举行的国际机器学习会议上发表的一篇论文中进行了详细介绍,该论文解决了全球日益增长的一个担忧,即个人和受版权保护的材料无限期地保留在人工智能模型中,因此模型用户可以访问这些材料,尽管原始创建者努力删除或使用付费墙和密码保护他们的信息。

该研究也发表在arXiv预印本服务器上。

UCR 的创新技术能够强制 AI 模型“忘记”特定信息,同时利用剩余数据保持模型的功能。这是一项重大进步,它能够修改模型,而无需使用大量原始训练数据重新构建模型,而这既耗费成本,又耗能。即使原始训练数据不再可用,该方法也能从 AI 模型中删除隐私信息。

“在现实世界中,你不可能总是能回到过去获取原始数据,”加州大学河滨分校电气与计算机工程博士生、该研究的主要作者尤米特·伊特·巴萨兰 (Ümit Yiğit Başaran) 说道。“我们创建了一个经过认证的框架,即使这些数据不再可用,它也能正常工作。”

这种需求迫在眉睫。科技公司面临着新的隐私法,例如欧盟的《通用数据保护条例》和加州的《消费者隐私法案》,这些法律规范了嵌入在大规模机器学习系统中的个人数据的安全。

此外,《纽约时报》还起诉 OpenAI 和微软,指控他们使用其多篇受版权保护的文章来训练生成式预训练 Transformer(GPT)模型。

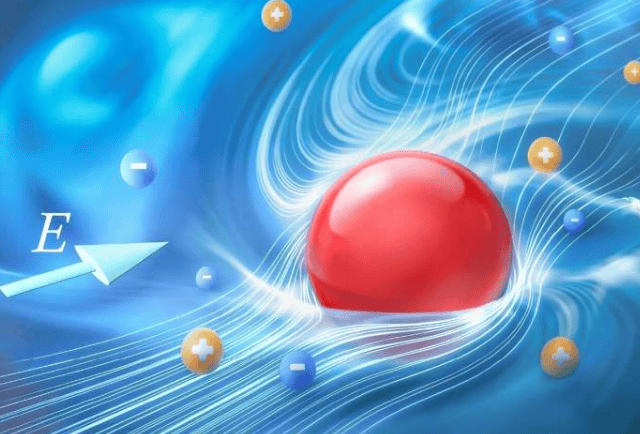

人工智能模型从互联网上抓取的海量文本中“学习”词汇模式。当用户提出疑问时,这些模型会预测最可能的词汇组合,并根据用户的提示生成自然语言响应。有时,它们会生成几乎逐字逐句的训练文本,让用户绕过内容创作者的付费墙。

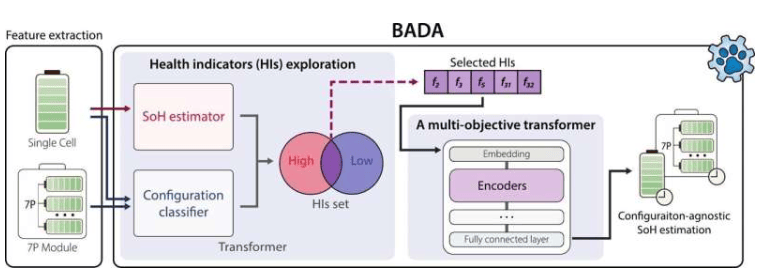

加州大学河滨分校的研究团队由巴萨兰、阿米特·罗伊-乔杜里教授和巴萨克·居勒助理教授组成,他们开发了一种名为“无源认证反学习”的方法。该技术允许人工智能开发人员使用统计上与原始数据相似的替代数据集(或称“替代数据集”)来删除目标数据。

该系统调整模型参数并添加经过精心校准的随机噪声,以确保目标信息被抹去并且无法重建。

他们的框架建立在人工智能优化的一个概念之上,该概念可以有效地近似地计算出模型从头开始重新训练后的变化。加州大学河滨分校的团队通过一种新的噪声校准机制增强了这种方法,该机制可以补偿原始数据集和替代数据集之间的差异。

研究人员使用合成数据集和真实数据集验证了他们的方法,发现它提供的隐私保证接近完全再训练所实现的隐私保证,但所需的计算能力却要少得多。

加州大学河滨分校 (UCR) 河滨人工智能研究与教育 (RAISE) 研究所联合主任、马兰和罗斯玛丽·伯恩斯工程学院教授 Roy-Chowdhury 表示,当前的研究适用于仍被广泛使用的简单模型,但最终可以扩展到 ChatGPT 等复杂系统。

研究人员表示,除了满足法规要求外,该技术还为媒体机构、医疗机构以及其他处理嵌入AI模型的敏感数据的机构带来了希望。它还可以让人们有权要求从AI系统中删除个人或受版权保护的内容。

“人们应该知道他们的数据可以从机器学习模型中删除——不仅是理论上,而且是可证明的、实际的方式,”Güler 说。

该团队的下一步计划包括改进方法,使其能够处理更复杂的模型类型和数据集,并构建工具,使全球的人工智能开发人员能够使用该技术。

这篇论文的标题是“一种无需访问源数据的认证反学习方法”。它是与纽约州厄普顿布鲁克海文国家实验室的计算科学研究员 Sk Miraj Ahmed 合作完成的,他在加州大学河滨分校获得了博士学位。

Roy-Chowdhury 和 Güler 都是电气与计算机工程系的教员,并在计算机科学与工程系兼职。

更多信息: Umit Yigit Basaran 等人,《一种无需访问源数据的认证反学习方法》,arXiv (2025)。期刊信息: arXiv