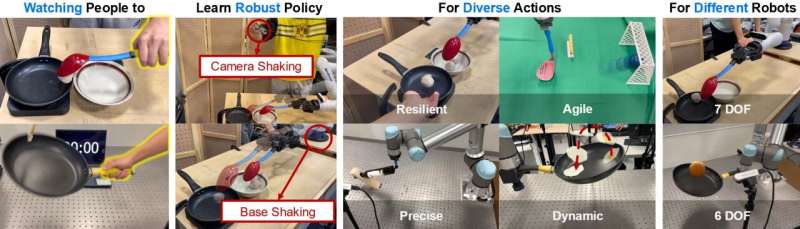

伊利诺伊大学香槟分校团队携手哥伦比亚大学和德克萨斯大学奥斯汀分校的合作者,在机器人学习领域取得重大突破。他们创建的“工具即界面”新框架,让机器人能够像孩子一样,仅通过观看人类日常工作的视频,就学会复杂、动态的工具使用技能,为机器人学习方式带来深刻转变。

传统机器人多是为执行特定重复性任务而编程,难以应对意外情况,适应新情况也需费力重新编程。而此次研究团队受孩子学习方式启发,旨在让机器人摆脱对专业操作员或专用硬件的依赖,实现自然观察学习。

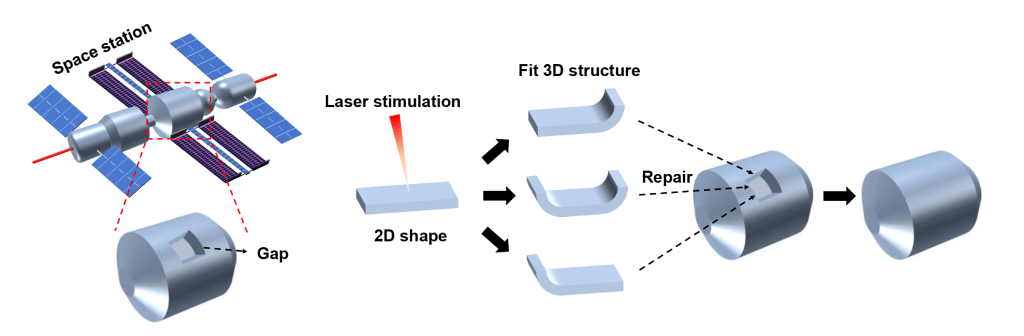

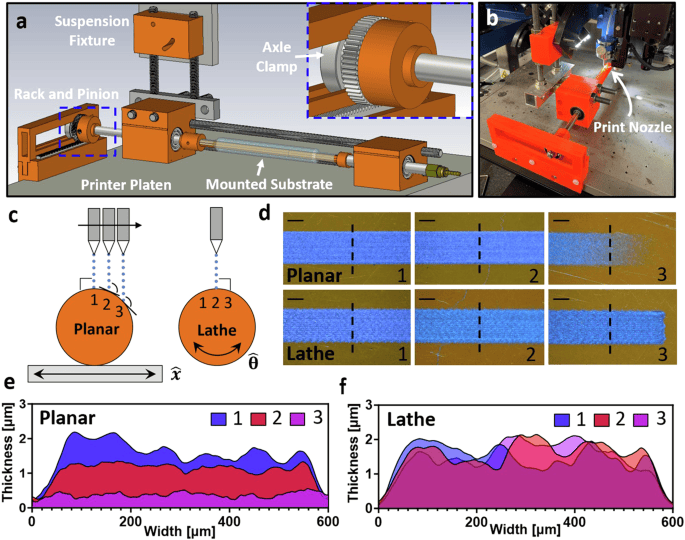

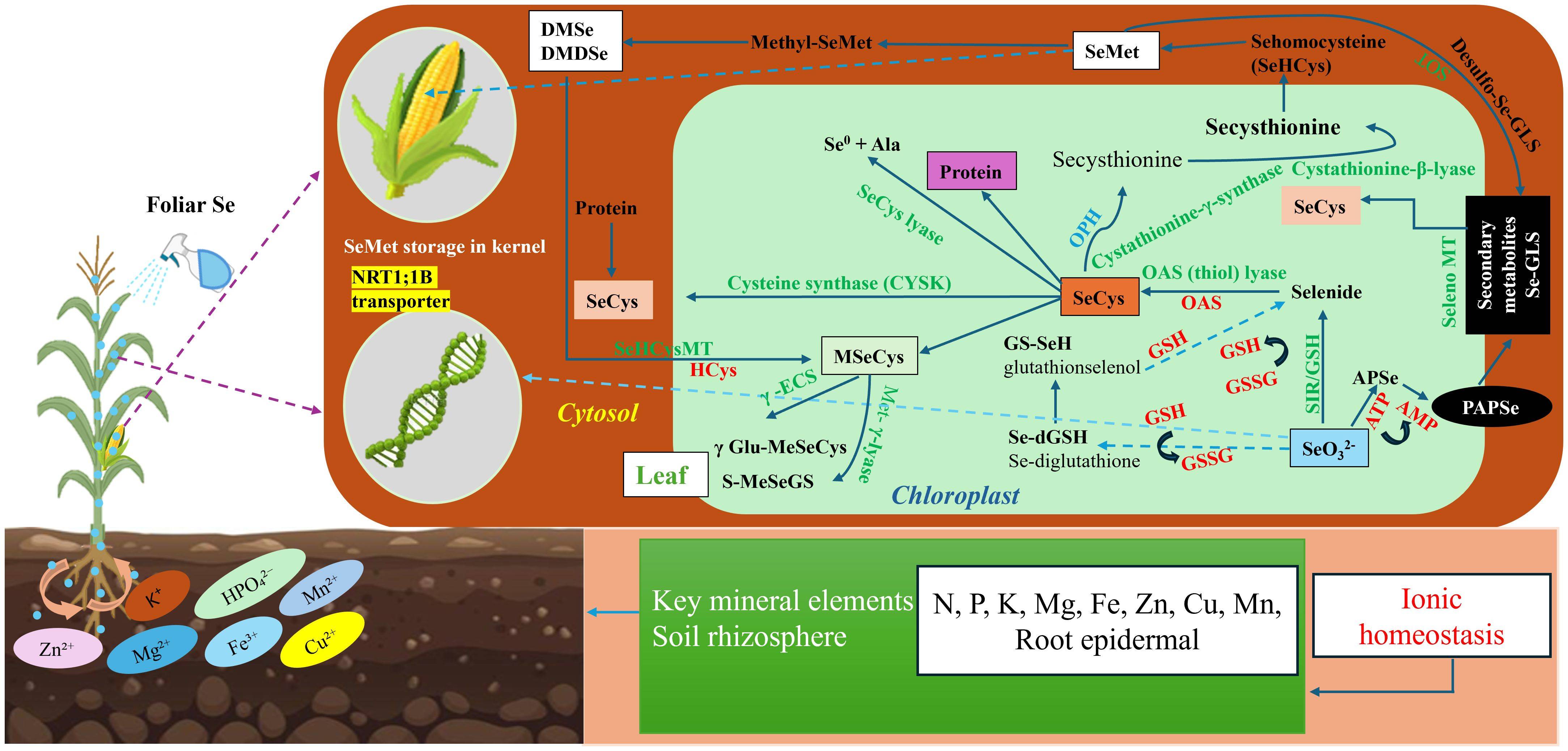

“工具即界面”框架目标明确,仅需两个摄像头拍摄的动作画面,用几部智能手机就能捕捉,通过特定流程教会机器人技能。首先,机器人从两帧视频开始,名为 MASt3R 的视觉模型利用这两帧视频重建场景三维模型;接着,使用 3D 高斯渲染方法生成额外视点,让机器人能从多个角度“观察”任务;然后,借助“Grounded-SAM”将人类从场景中移除,系统只隔离工具及其与环境的交互,使机器人学习工具本身的精确轨迹和方向,而非模仿人类手部动作,这让技能可在不同机器人间迁移。

研究团队对敲钉子、舀肉丸、在锅里翻动食物、平衡酒瓶、将足球踢进球门等五项任务进行测试。这些任务需速度、精度和适应性,并非简单的拾取和放置工作。结果显示,与传统远程操作方法相比,“工具即界面”框架成功率提高了 71%,训练数据收集速度提高了 77%。在测试中,机器人能灵活适应人类中途加入更多肉丸等情况,还能完成遥控机器人难以做到的在锅里翻动松散鸡蛋等动作。

领导实验室的凯蒂·德里格斯·坎贝尔教授表示,团队致力于设计框架和算法,让机器人以最少工程工作量轻松向人类学习。不过,目前该系统仍面临挑战,如假设工具牢固固定在机器人夹持器上在现实中不总是成立,有时会出现 6D 姿态估计误差,角度偏移过大时合成摄像机视图会失真等。

尽管如此,这项研究意义重大。数十亿个摄像头记录着人类使用工具的过程,有了合适算法,这些视频可成为下一代适应性强、实用性高的机器人的训练材料。目前,该研究已在 ICRA 2025 机器人基础模型和神经符号 (NeSy) AI 研讨会上荣获最佳论文奖,成为释放机器人学习潜力、将人类录制视频转化为机器人全球训练库的关键一步。

更多信息: Haonan Chen 等,《工具即界面:通过模仿学习从人类工具使用中学习机器人策略》,arXiv (2025)。