为帮助机器提升理解世界所需的视觉感知能力,研究人员开发了新型训练数据集RoboSpatial,旨在提高机器人的空间感知能力。在一项新研究中,使用RoboSpatial数据集训练的机器人,在相同任务中表现优于使用基线模型训练的机器人,展现出对空间关系和物理对象操作的复杂理解。

人类视觉感知塑造了与环境互动方式,而机器人此前因数据缺乏复杂空间理解能力,相关技能提升收效甚微。俄亥俄州立大学工程系博士生卢克·宋指出,深度空间理解是直观交互必需,空间推理挑战若不解决,会阻碍未来人工智能系统理解复杂指令和在动态环境运行的能力。他说:“要拥有真正通用的基础模型,机器人需要理解周围的三维世界,空间理解是机器人最重要的能力之一。”

RoboSpatial数据集包含超百万张真实世界室内和桌面图像、数千张精细3D扫描图以及三百万个描述与机器人相关的丰富空间信息的标签。利用这些资源,该框架将二维以自我为中心的图像与同一场景完整3D扫描图配对,使模型能学习用平面图像识别或3D几何方法精确定位物体。与现有训练数据集相比,RoboSpatial能在实际机器人任务中严格测试空间推理能力,先演示物体重排,再检验模型在新空间推理场景中的泛化能力。

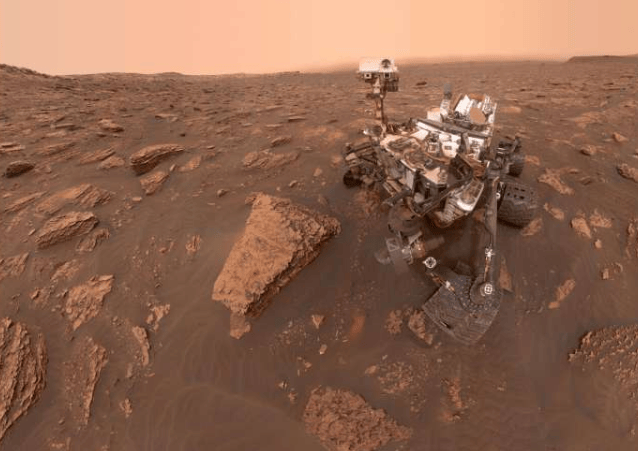

团队测试系统之一的Kinova Jaco机器人,作为辅助手臂可帮助残疾人士与周围环境建立联系。训练中,它能正确回答简单封闭式空间问题,如“椅子可以放在桌子前面吗?”或“杯子在笔记本电脑的左边吗?”。卢克·宋表示,这些结果意味着通过提高机器人感知能力规范空间环境,可带来更安全、可靠的人工智能系统。尽管人工智能开发训练仍有诸多未解之谜,但RoboSpatial有潜力成为机器人领域更广泛应用的基础,更令人兴奋的空间技术进步或由此衍生。

更多信息: Chan Hee Song 等人,《RoboSpatial:为机器人学中的二维和三维视觉语言模型教授空间理解》,2025 年 IEEE/CVF 计算机视觉与模式识别会议 (CVPR) (2025)。