滑铁卢大学开发出一种新型训练方法——SubTrack++,旨在降低构建人工智能(AI)工具的成本与环境影响,推动人工智能工具的普及化进程。大型语言模型(LLM)作为先进的人工智能系统,其训练过程长久以来受限于高昂的成本与巨大的资源消耗,使得除大型企业与组织外,难以广泛涉足。

滑铁卢大学的研究团队历经一年多的努力,融合并发展了以往的培训改进工作,成功研发出SubTrack++技术。该技术显著提升了LLM模型的预训练速度,增幅达50%,同时保持了超越现有先进水平的准确度。西里沙·兰巴特拉博士指出:“这些模型规模庞大,能耗惊人,因此即便性能提升有限,也能带来显著效益。”

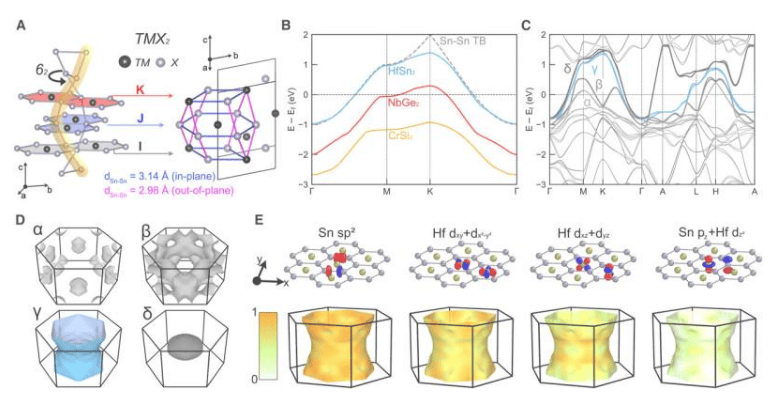

SubTrack++技术的核心在于简化校正过程,通过聚焦模型的关键参数,加速预训练阶段的模型构建,为后续特定任务的微调奠定坚实基础。领导研究的萨哈尔·拉贾比博士形象地比喻道:“训练过程如同让模型阅读整个图书馆,通过识别词语与思想中的模式来学习语言使用。”而SubTrack++则通过优化这一过程,使得模型能够更快地掌握语言规律。

研究人员期望,随着LLM培训速度的提升与成本的降低,普通人将能够负担得起并构建自己的强大AI工具。拉贾比博士进一步畅想:“未来的LLM模型有望成为个性化数字助理,适应每个人的独特风格、目标与需求,成为人类工作与创造力的智能伙伴。”

滑铁卢大学计划在即将于墨西哥城举行的神经信息处理系统会议(NeurIPS 2025)上发表关于SubTrack++技术的论文,进一步分享这一研究成果。

更多信息:技术名称: SubTrack++:用于可扩展LLM训练的梯度子空间跟踪。