超大规模AI数据中心崛起

2026-01-15 14:27

收藏

超大规模数据中心正以革命性架构为AI模型提供强大动力,成为科技竞赛的新焦点。如今,在农田与工业园区中,专为训练和运行超大规模大语言模型设计的超级计算机建筑群拔地而起。这些数据中心配备专用芯片、冷却系统及独立能源供应,将数十万图形处理单元(GPU)捆绑成集群,如英伟达H100芯片,擅长并行处理海量数据。光纤电缆如神经系统般连接芯片,实现闪电通信,而庞大存储系统则持续为芯片输送数据。OpenAI、谷歌、亚马逊、微软和Meta等科技巨头,以及中国、美国、中东等国家政府,均向此类基础设施投入巨额资金。

然而,惊人算力背后是高昂的能源成本。密集排列的芯片产生极高热量,传统空调无法满足冷却需求,需采用冷水板或冷却液浴技术,未来甚至可能浸入海水冷却。最大型数据中心耗电量或超一吉瓦,相当于整座城市用电量,其中超半数电力来自化石燃料,可再生能源仅占四分之一多一点。面对能源压力,部分AI企业开始探索核能,谷歌更设想在太空建立太阳能数据中心。

数据中心疯狂扩建,源于AI扩展定律及技术应用的爆炸性需求。但这一趋势正给社区带来能源账单飙升、水资源短缺、噪音污染及空气污染等问题,公众或将为此买单。如何在推动AI发展的同时,平衡能源消耗与环境保护,成为亟待解决的课题。

本简讯来自全球互联网及战略合作伙伴信息的编译与转载,仅为读者提供交流,有侵权或其它问题请及时告之,本站将予以修改或删除,未经正式授权严禁转载本文。邮箱:news@wedoany.com

相关推荐

博通推出支持6G的大规模MIMO数字前端SoC BroadPeak

2026-03-02

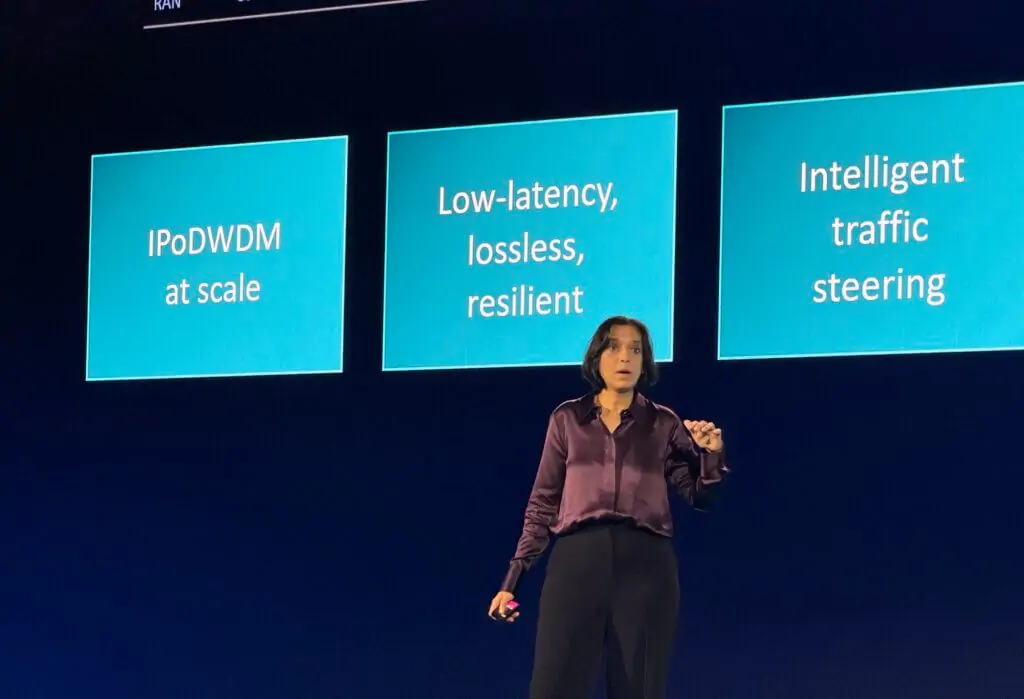

诺基亚整合GPU与光传输构建确定性AI网络

2026-03-02

AI冲击下SaaS商业模式面临定价与竞争挑战

2026-03-02

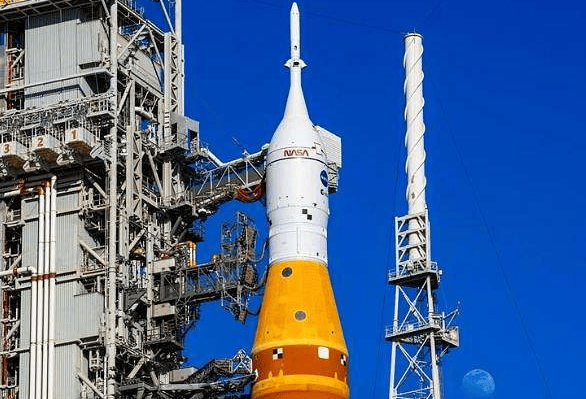

NASA调整阿耳忒弥斯月球计划,增加测试任务以应对技术延误

2026-03-02

NASA宇航员迈克·芬克从国际空间站撤离后健康状况良好

2026-03-02

诺基亚CEO称AI成为新型主导网络工作负载

2026-03-02

谷歌与Bharti Airtel电信合作在印度RCS生态中整合垃圾信息过滤功能

2026-03-02

OpenAI完成1100亿美元融资,亚马逊领投500亿,投前估值达7300亿美元

2026-03-02

OpenAI公布与五角大楼合作细节 强调安全防护措施

2026-03-02

华为将在MWC 2026发布Agentic Core方案,推动智能体网络商用

2026-03-02

最新简讯

1

美国NASA测试证实:太阳能化学反应可从月球土壤提取氧气,支持阿尔忒弥斯计划

2

中国华润建材科技首席财务官变更 杨敏接任新职

3

Interact Analysi预测欧洲引领高效电机市场增长

4

美国ISM制造业PMI连续两月扩张 2月指数52.4

5

美国钢动力公司Barry Schneider获2025年度钢铁行业执行官荣誉

6

IFS收购Softeon整合工业AI与仓库管理系统

7

英国制造业2026年开局良好PMI连续扩张新订单增长

8

Anaergia携手CREvolution在意大利启动首例脱胶土壤回收项目

9

澳大利亚Stockland金斯森林项目首批住宅地块完成交割,推动绿地社区建设

10

美国Werner Enterprises等公司专属卡车运输业务增长 市场迈向成熟