近日,密歇根大学的研究团队开发出一种新的可解释人工智能(AI)技术,该技术能够在不影响分类准确性的前提下,透明地对图像进行分类。这一创新为人工智能在医学诊断等高风险领域的应用开辟了新路径,在这些领域中,理解AI决策的原因与决策本身同样重要。

密歇根大学工业与运营工程助理教授萨拉尔·法塔希表示:“我们需要值得信赖的人工智能系统,尤其是在医疗保健等领域。如果我们不了解模型如何做出决策,就无法安全地依赖它。”该研究将于7月17日在国际机器学习大会上发表,展示了新框架——约束概念细化(CCR)的潜力。

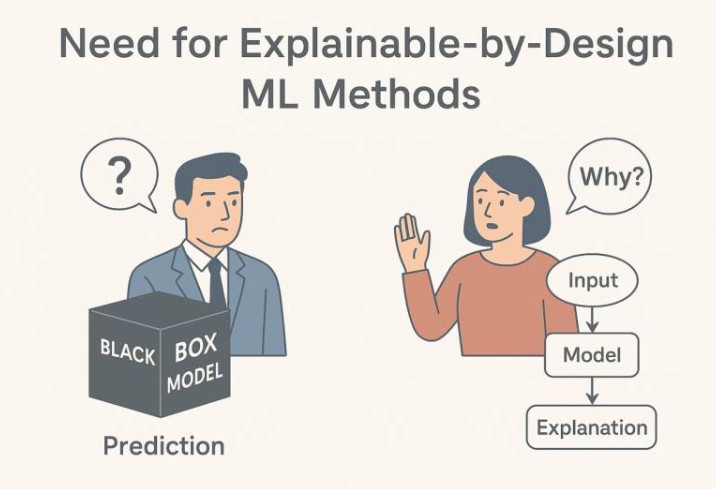

传统的可解释AI方法在模型构建后添加可解释性功能,但往往无法真正解释其决策过程,且概念嵌入被视为固定数值向量,可能包含错误或失实表述。而CCR框架则通过将可解释性直接嵌入并优化到模型架构中,解决了这些问题。它允许概念嵌入具有一定的灵活性,以适应特定任务,从而提高模型的准确性和可解释性。

在对CIFAR10/100、Image Net、Places365等图像分类基准的测试中,CCR方法在预测准确率方面优于两种可解释方法,同时保持了可解释性。更重要的是,新方法将运行时间缩短了十倍,以更低的计算成本提供了更佳的性能。

密歇根大学工业与运营工程博士研究生梁格宇表示,虽然目前的实验重点是图像分类,但CCR方法的低实施成本和易于调整的特点表明,它在不同的机器学习领域具有更广泛的应用潜力。例如,在金融领域,可解释的AI可以提高贷款资格审核的透明度和公平性,确保决策基于具体因素,而非偏见或不相关的信息。

法塔希教授对CCR方法的未来充满信心:“我们只是触及了表面。我们的工作提供了强有力的证据,证明可解释性可以以一种高效和低成本的方式融入现代人工智能。”

更多信息: Geyu Liang 等,通过约束概念细化增强可解释人工智能模型的性能,arXiv (2025)。期刊信息: arXiv