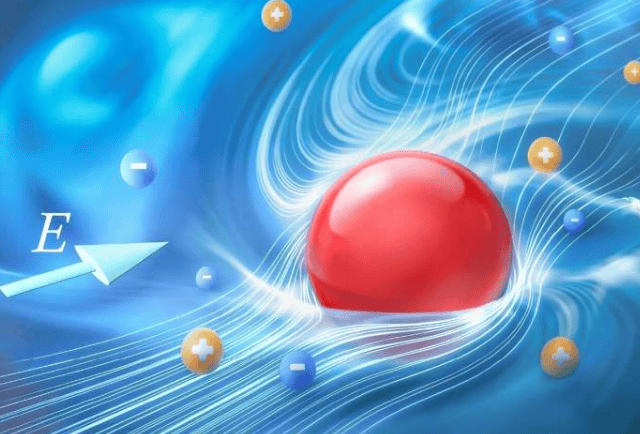

安全研究人员成功开发出首个功能性防御机制,有效抵御针对人工智能系统模型参数的“密码分析”攻击。人工智能系统作为极具价值的知识产权,其模型参数的窃取一直是行业面临的重大威胁。北卡罗来纳州立大学博士生阿什利·库里安,作为相关论文的第一作者表示:“我们的技术能够有效地抵御这些攻击。”

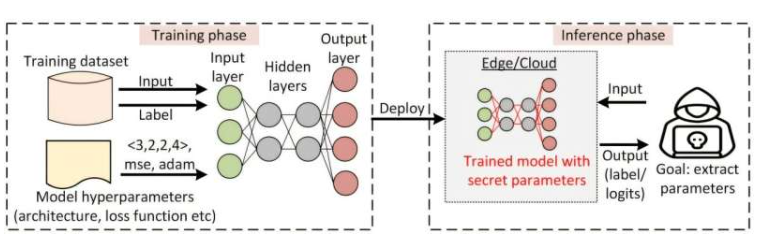

密码分析参数提取攻击,通过数学方法确定人工智能模型参数,使第三方能够重新创建系统,对商业AI系统,尤其是神经网络模型构成严重威胁。论文通讯作者艾丁·艾苏指出:“密码分析攻击已愈发频繁且有效,我们急需防御机制,防止模型参数被窃取。”

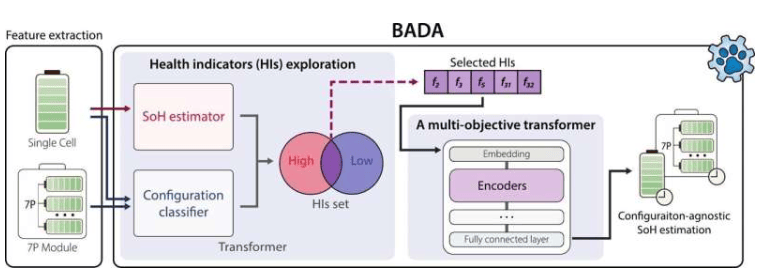

新防御机制基于研究人员对攻击核心原则的洞见,即攻击主要针对神经元之间的差异。库里安解释:“我们训练神经网络模型,使同一层中的神经元彼此相似,建立‘相似性屏障’,增加攻击难度。”在概念验证测试中,融入防御机制的人工智能模型准确率变化不到1%,且能有效抵御长时间密码分析攻击。

此外,研究团队还开发了一个理论框架,量化密码分析攻击的成功概率,无需长时间攻击测试即可评估模型抵御能力。库里安表示:“我们乐观地认为,这种机制将被用于保护人工智能系统,并愿意与行业伙伴合作实施。”艾苏也强调,安全防护与黑客攻击之间存在持续拉锯战,期待未来能有更多资源支持新安全措施的研发。

该研究成果论文《训练防御:抵御密码分析神经网络参数提取攻击的第一道防线》将在12月2日至7日于加利福尼亚州圣地亚哥举行的第三十九届神经信息处理系统年会上发表。

更多信息: Ashley Kurian 等人,《训练防御:抵御密码分析神经网络参数提取攻击的第一道防线》,arXiv (2025)。期刊信息: arXiv