Google DeepMind 新 AI 模型Gemini Robotics提升机器人任务执行能力,无需特定训练

2025-03-16 16:05

收藏

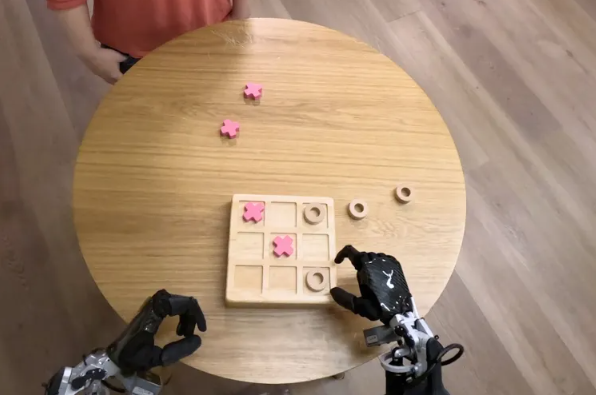

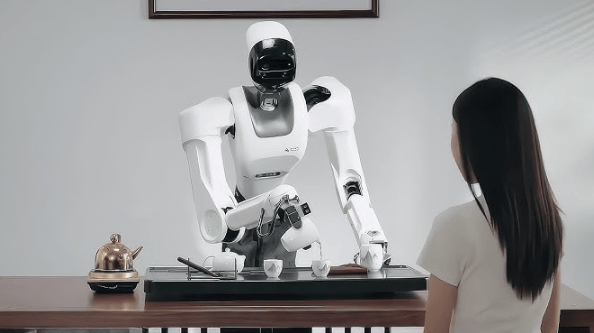

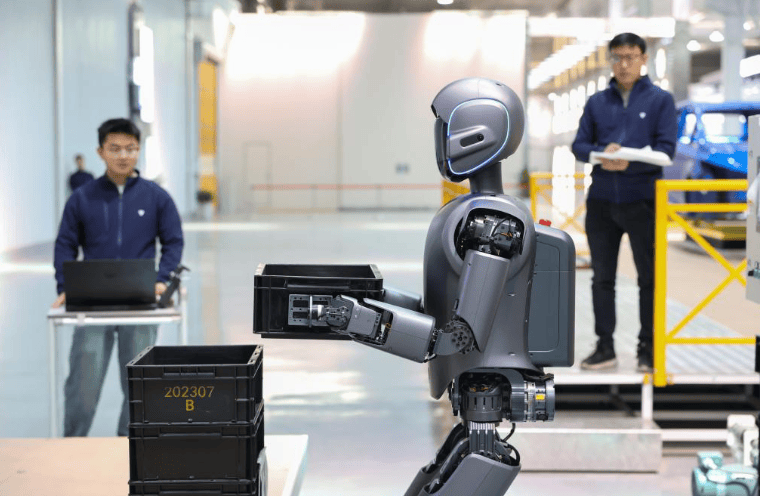

Google DeepMind 推出两款 AI 模型,旨在扩展机器人执行现实任务的范围。Gemini Robotics 基于 Gemini 2.0,具备视觉-语言-行动能力,可理解新情境,无需针对特定任务训练。Google DeepMind 机器人技术负责人 Carolina Parada 表示,Gemini Robotics 利用 Gemini 的多模态理解,将物理动作作为新输出模式,应用于现实世界。模型在通用性、交互性和灵巧性三方面取得进展,适应新场景,与人类及环境互动更顺畅,执行折纸、开瓶盖等精细任务。Parada 强调,Gemini Robotics 在三领域性能大幅提升,构建更强大、响应更快、对变化更稳健的机器人。

Gemini Robotics-ER 聚焦具身推理,强化空间理解,专为机器人专家设计,可与现有低级控制器集成,支持新功能开发。Parada 举例,打包午餐盒需识别物品位置、打开容器、抓取并放置物品,Gemini Robotics-ER 能执行此类推理。Google DeepMind 研究员 Vikas Sindhwani 表示,模型采用分层安全策略,评估行动安全性。公司发布新基准和框架,推进 AI 安全研究,2024 年推出受阿西莫夫三定律启发的“机器人宪法”,规范机器人行为。

Google DeepMind 与 Apptronik 合作开发下一代人形机器人,Gemini Robotics-ER 向 Agile Robots、Agility Robotics、Boston Dynamics 和 Enchanted Tools 等测试者开放。Parada 表示,目标是构建理解并作用于物理世界的智能,模型将在多领域应用,助力机器人技术进步。

本简讯来自全球互联网及战略合作伙伴信息的编译与转载,仅为读者提供交流,有侵权或其它问题请及时告之,本站将予以修改或删除,未经正式授权严禁转载本文。邮箱:news@wedoany.com

相关产品

相关推荐

人工智能在法律市场预计2030年达124.9亿美元,年复合增长率22.3%

2026-01-30

摩尔多瓦全国人工智能奥林匹克竞赛首次举办

2026-01-30

人形机器人商业化落地或快于新能源汽车,高价值环节受关注

2026-01-30

foodpanda运用数据与人工智能提升亚太地区零工经济骑手安全

2026-01-29

康奈尔大学任命Thorsten Joachims为人工智能战略副教务长协调AI发展

2026-01-29

AfricAI与Micropolis Robotics合作在非洲部署智能机器人系统

2026-01-29

AWS推新功能:强化生成式人工智能流量过滤与安全防护

2026-01-29

通光线缆回应:柔性电缆暂未涉足人形机器人领域

2026-01-29

中国机器人公司埃夫特机器人因成本攀升,调整部分产品售价

2026-01-29

中国北京人形机器人中试验证平台启动,第1000台定制样机下线

2026-01-29

最新简讯