超级马里奥成为 AI 基准测试新挑战

加州大学圣地亚哥分校的 Hao AI Lab 近日将经典游戏《超级马里奥兄弟》引入 AI 基准测试,探索人工智能在实时互动环境中的表现。研究人员利用自行开发的 GamingAgent 框架,在模拟器中运行游戏,让 AI 控制马里奥完成任务。测试结果显示,Anthropic 的 Claude 3.7 表现最佳,Claude 3.5 次之,而谷歌的 Gemini 1.5 Pro 和 OpenAI 的 GPT-4o 则明显力不从心。

GamingAgent 框架为 AI 提供屏幕截图和基本指令,如“若附近有障碍物或敌人,向左移动或跳跃躲避”。AI 通过生成 Python 代码输入,实时操控马里奥。研究表明,这种设置要求模型具备复杂规划和策略制定能力。令人意外的是,通常在传统基准测试中表现优异的推理模型(如 OpenAI 的 o1),在游戏中却逊于非推理模型。原因在于推理模型需数秒“思考”决策,而《超级马里奥兄弟》瞬息万变,延迟可能导致失败。

游戏作为 AI 测试工具已有数十年历史,但其抽象性和相对简单性使其与现实世界的复杂性存在差距。尽管游戏能提供海量训练数据,部分专家质疑其能否真正反映 AI 的技术进步。OpenAI 研究科学家 Andrej Karpathy 近期在 X 平台发文,提到当前的“评估危机”,表示难以判断现有指标是否足以衡量模型能力。

此次测试虽非 1985 年原版《超级马里奥兄弟》,但通过模拟器与 AI 的结合,展现了人工智能在动态环境中的潜力与局限。Claude 3.7 的突出表现表明,其设计可能更适应快速决策需求。相比之下,Gemini 1.5 Pro 和 GPT-4o 的挣扎揭示了当前主流模型在实时任务中的短板。

本简讯来自全球互联网及战略合作伙伴信息的编译与转载,仅为读者提供交流,有侵权或其它问题请及时告之,本站将予以修改或删除,未经正式授权严禁转载本文。邮箱:news@wedoany.com

相关推荐

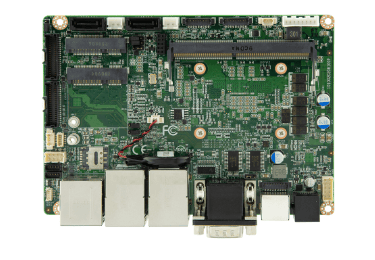

AI驱动PCB布局工具Quilter成功实现单板计算机设计

2026-02-02

Fusion发布一月绿皮书:半导体市场动态与供应趋势分析

2026-02-02

机器人实时推理与Palladyne AI在自主感知领域的进展

2026-02-02

类人机器人投资机遇与Humanoid Global战略布局

2026-02-02

EMASS16纳米ECS-DoT芯片成功流片,推动边缘AI技术发展

2026-02-02

易格斯无卤Chainflex TPE电缆获干式洁净室4级与5级认证

2026-02-02

星巴克推出AI点单助手优化咖啡订购体验

2026-02-02

加拿大阿尔伯塔省27个高速互联网项目启动,惠及8.3万家庭

2026-02-02

Fitbit用户需在2026年5月前将数据迁移至谷歌账户

2026-02-02

荷兰量子技术面临90亿欧元资金缺口,需投资应对规模化挑战

2026-02-02

最新简讯

1

中国浙江普利药业玛巴洛沙韦片获批,丰富中国抗流感药物市场

2

Stepnell完成英国牛津大学分子生理学实验室翻新项目

3

韩国新型抗生素Fetroja上市,为多重耐药菌感染患者带来新希望

4

Webuild赢得意大利SS106国道公路建设项目合约

5

长春高新子公司GS3-007a干混悬剂临床试验申请获受理

6

泰勒·温佩获准在英国波尔蒙特启动新住宅区建设项目

7

英国苏格兰推出8000万英镑公共建筑屋顶改造框架协议

8

国际医疗集团HCA Healthcare应用人工智能技术优化运营与临床辅助

9

AI驱动PCB布局工具Quilter成功实现单板计算机设计

10

科学家破解50年谜团发现MAL新血型系统